Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nok en alfalekkasje. samme teknikk som vi brukte for KernelBench. Det er en universell tilnærming i sin enkleste form.

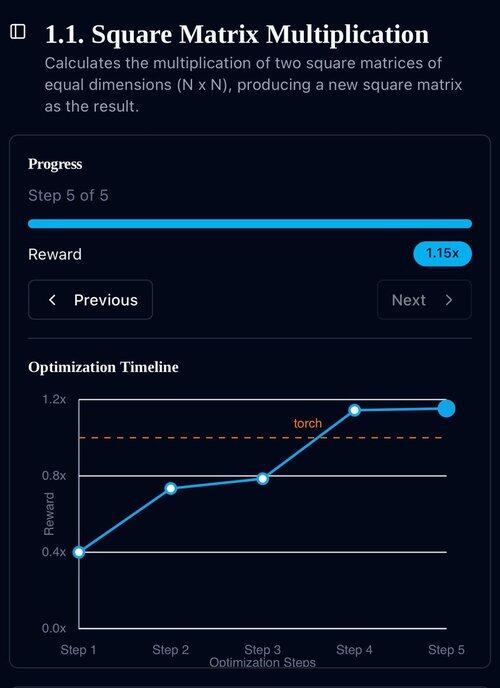

Eksempler er alt du trenger: få ett godt resultat eller én enkelt forbedring, legg til kontekst, få flere gode resultater med forbedret kontekst, legg dem til i kontekst, annonseinformasjon ...

22. juli, 11:19

Nylig nådde Openai, Goolge IMOs gullmedalje med sine nye eksperimentelle modeller.

Men teamet vårt nådde samme nivå med bare o4-mini-high og agentsystemene våre. Og nå åpner vi den.

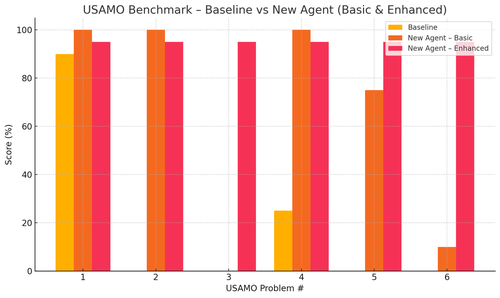

Spesielt fikk vi vanvittige forbedringer med USAMO-benchmarkene. Grunnlinjen var nesten 0, men agenten vår fikk gjennomsnittlig 90 %.

Vi kan også teoretisk bevise de nylige arxiv-artiklene som bare gir nøkkelforskningens idé.

Det er ingen vits i å trene små modeller egentlig ... du er bedre å finne det ideelle programmet for å mate til de største maskinene.

Hvis du vil ha den beste utgangsfordelingen, må du finne den ideelle inngangsdistribusjonen, som praksis.

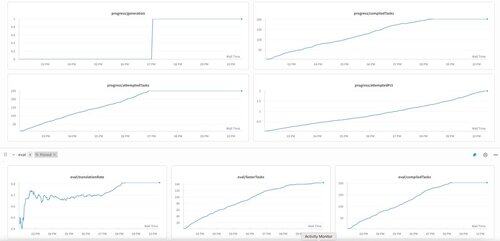

Du kan komme dit fra ingenting så lenge du har en måte å rangere resultatene dine på.

Disse guttas teknikk virker overkonstruert, kan sannsynligvis være mye enklere.

KernelBenchs første generasjon på o3-mini. Vi kalte dette bare «selvforbedring».

30. apr. 2025

vi har et ubekreftet SOTA-resultat på KernelBench med o3-mini og et evolusjonært eksempelbånd: 208/250 påståtte hastigheter, inkludert 3 for nivå 4 (forrige urørt).

ville være takknemlig for all hjelp til å gjennomgå de optimaliserte KernelBench-kjernene på .

takk til @anneouyang og Stanfords @ScalingIntelLab for at du gikk med på å vurdere dem.

3,3K

Topp

Rangering

Favoritter