Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

outra fuga de alpha. a mesma técnica que usamos para o KernelBench. é uma abordagem universal na sua forma mais simples.

exemplos são tudo o que você precisa: obtenha um bom resultado ou uma única melhoria, adicione ao contexto, obtenha mais bons resultados com o contexto melhorado, adicione esses ao contexto, ad inf...

22/07, 11:19

Recentemente, a OpenAI e o Google alcançaram a medalha de ouro do IMO com seus novos modelos experimentais.

Mas a nossa equipe alcançou o mesmo nível apenas com o o4-mini-high e nossos sistemas de agentes. E agora estamos tornando isso open source.

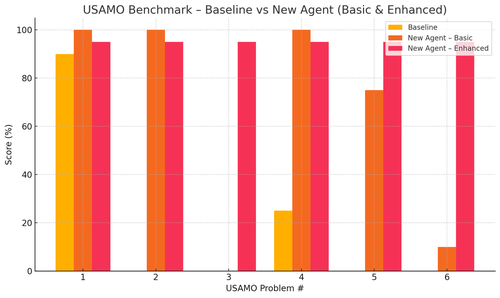

Especialmente, obtivemos melhorias incríveis com os benchmarks do USAMO. A linha de base era quase 0, mas nosso agente obteve uma média de 90%.

Além disso, conseguimos provar teoricamente os recentes artigos do arxiv apenas apresentando a ideia-chave da pesquisa.

não faz sentido treinar modelos pequenos, realmente... é melhor encontrar o programa ideal para alimentar as máquinas maiores.

se você quer a melhor distribuição de saída, precisa encontrar a distribuição de entrada ideal, como a prática.

você pode chegar lá do nada, desde que tenha uma maneira de classificar suas saídas.

a técnica desses caras parece superdimensionada, pode ser muito mais simples.

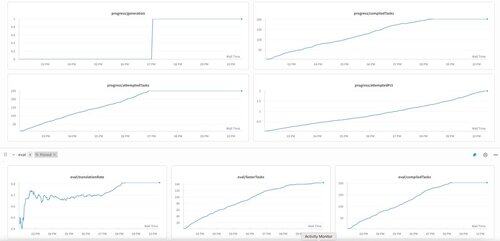

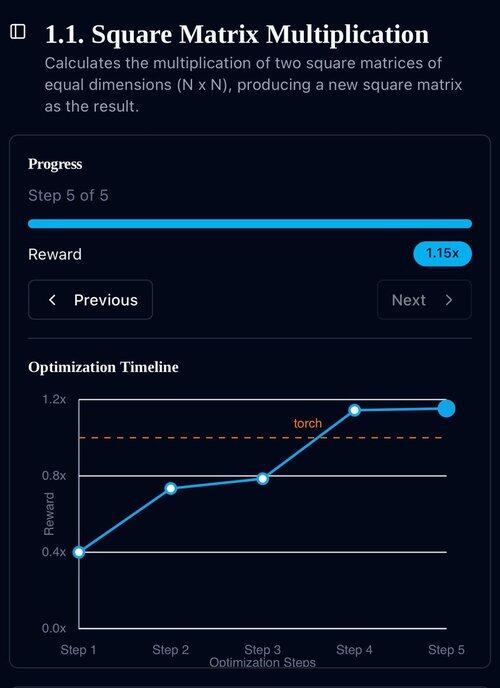

A primeira geração do KernelBench no o3-mini. Nós apenas chamamos isso de "autoaperfeiçoamento."

30/04/2025

temos um resultado SOTA não verificado no KernelBench com o3-mini e uma fita de exemplos evolutivos: 208/250 acelerações reivindicadas, incluindo 3 para o Nível 4 (prev intocado).

ficaria grato por qualquer ajuda na revisão dos kernels otimizados do KernelBench em .

obrigado a @anneouyang e ao @ScalingIntelLab de Stanford por concordarem em revê-los.

3,27K

Top

Classificação

Favoritos