Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Waarom pre-trainings- en post-trainingsgroepen goed met elkaar moeten opschieten

18 jul, 06:21

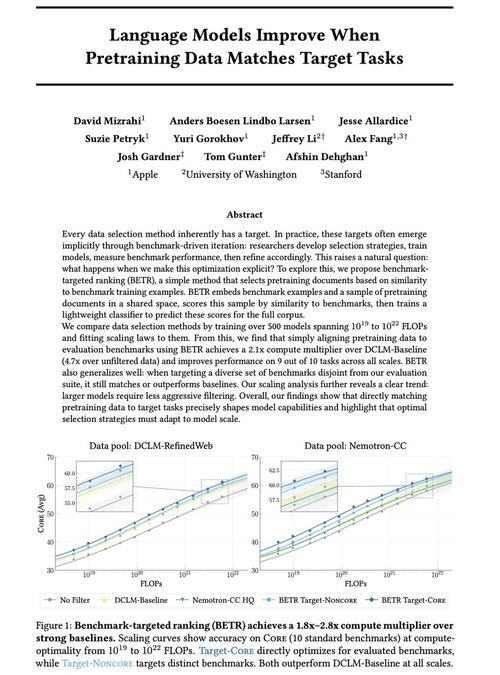

We zijn enthousiast om ons nieuwe werk te delen: “Taalmodellen Verbeteren Wanneer Voortrainingsdata Overeenkomt met Doelstellingen”

Ja, het klinkt voor de hand liggend (en dat is het ook!), maar meestal gebeurt dit alleen impliciet en indirect: intuïtief data selecteren → benchmark → verfijnen → herhalen.

We vroegen ons af: wat gebeurt er als we de voortrainingsdata expliciet afstemmen op benchmarks? Het resultaat is een doodsimpele aanpak die 2x+ rekencapaciteit oplevert ten opzichte van sterke baselines en ons een principiële manier biedt om te bestuderen hoe de keuze van benchmarks de (en beperkt!) modelcapaciteiten vormgeeft.

Bonus: uitgebreide schalingwetten van het trainen van 500+ modellen die onthullen hoe optimale dataselectie evolueert naarmate modellen opschalen.

🧵 (1/14)

2,72K

Boven

Positie

Favorieten