Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Почему командам предтренировки и посттренировки нужно ладить

18 июл., 06:21

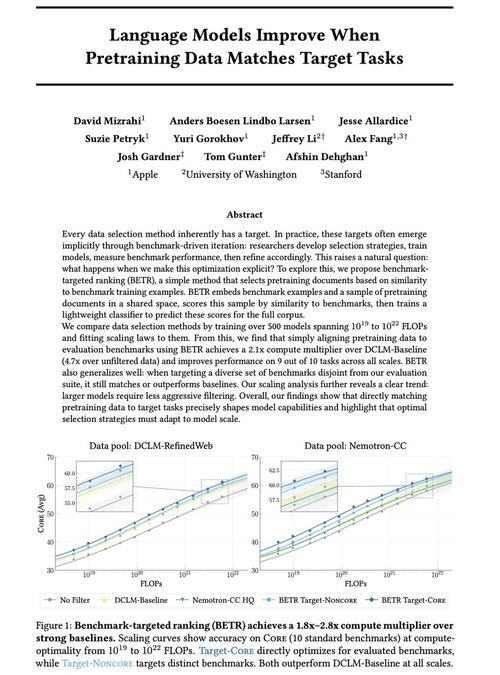

Рады поделиться нашей новой работой: "Языковые модели улучшаются, когда данные для предварительного обучения соответствуют целевым задачам"

Да, это звучит очевидно (и так оно и есть!), но обычно это происходит только неявно и косвенно: интуитивно выбираем данные → бенчмаркинг → уточнение → повторение.

Мы задумались: что произойдет, если мы явно сопоставим данные для предварительного обучения с бенчмарками? Результат — очень простой подход, который дает 2x+ множители вычислений по сравнению с сильными базовыми моделями и предоставляет нам принципиальный способ изучения того, как выбор бенчмарков формирует (и ограничивает!) возможности модели.

Бонус: обширные законы масштабирования от обучения 500+ моделей, которые показывают, как оптимальный выбор данных эволюционирует по мере масштабирования моделей.

🧵 (1/14)

2,72K

Топ

Рейтинг

Избранное