Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Știați că SGD vanilie în loturi mici fără impuls (adică primul optimizator despre care aflați în ML introductiv) este practic la fel de rapid ca AdamW pentru preantrenamentul LLM pe FLOP? 📜 1/n

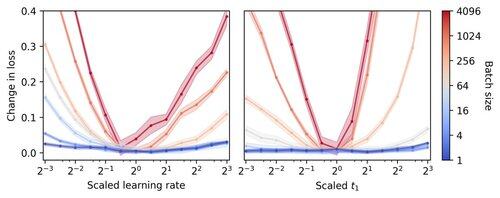

Se crede că antrenamentul LLM în loturi mici este lent pe FLOP, motivând acumularea de gradient pentru a simula loturi mai mari, chiar și în curse academice la scară mică. Arătăm că o regulă simplă pentru scalarea hiperparametrilor Adam permite antrenamentul eficient pe FLOP până la dimensiunea lotului 1. 4/n

Observăm că antrenamentul în loturi mici este foarte robust pentru a optimiza hiperparametrii precum rata de învățare și impulsul. Aceasta înseamnă că pe un buget fix de reglare a hiperparametrilor, veți găsi hiperparametri mai buni în regimul de loturi mici. 6/n

341,24K

Limită superioară

Clasament

Favorite