Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Visste du att vanilj SGD i små partier utan momentum (dvs. den första optimeraren du lär dig om i intro ML) är praktiskt taget lika snabb som AdamW för LLM-förträning per FLOP? 📜 1/n

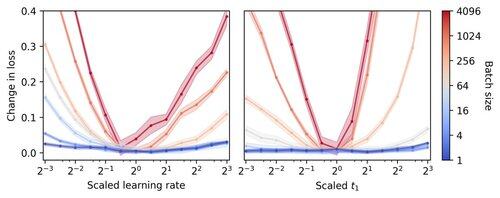

LLM-träning i små partier tros vara långsam per FLOP, vilket motiverar gradientackumulering för att simulera större satser, även i småskaliga akademiska körningar. Vi visar att en enkel regel för skalning av Adam-hyperparametrar möjliggör effektiv träning per FLOP ner till batchstorlek 1. 4/n

Vi observerar att träning av små batchar är mycket robust för att optimera hyperparametrar som inlärningshastighet och momentum. Det innebär att med en fast budget för justering av hyperparametrar hittar du bättre hyperparametrar i systemet med små batchar. 6/n

341,24K

Topp

Rankning

Favoriter