Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Чи знаєте ви, що дрібносерійний ванільний SGD без імпульсу (тобто перший оптимізатор, про який ви дізнаєтеся у вступному ML) практично такий же швидкий, як AdamW для попереднього навчання LLM на основі FLOP? 📜 1/п

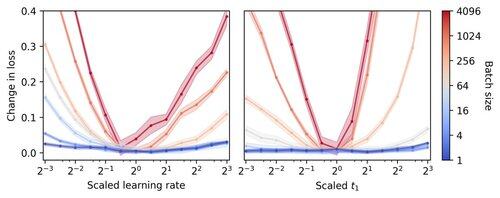

Вважається, що тренування LLM у невеликих партіях відбувається повільно на FLOP, що мотивує градієнтне накопичення для імітації більших партій, навіть у невеликих академічних забігах. Показано, що просте правило масштабування гіперпараметрів Адама дозволяє ефективно тренуватися на FLOP аж до розміру партії 1. 4/п

Ми спостерігаємо, що тренування малими партіями є дуже стійкими до гіперпараметрів оптимізатора, таких як швидкість навчання та імпульс. Це означає, що при фіксованому бюджеті на тюнінг гіперпараметрів ви знайдете кращі гіперпараметри в режимі малої партії. 6/п

341,22K

Найкращі

Рейтинг

Вибране