المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

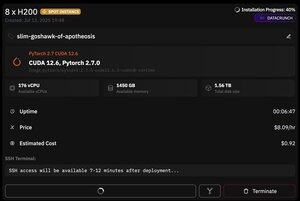

ولكن ما يميز @PrimeIntellect هو توفر المثيلات الموضعية - اليوم حصلت على عقدة مع 8xH200 مقابل 8 دولارات فقط في الساعة!

سأوضح كيف أقوم بإعداد الاستدلال moonshotai / Kimi-K2-Instruct بسرعة باستخدام vllm

1. بعد الحصول على وصول SSH إلى الجراب الخاص بك (انتظر حوالي 10 دقائق) ، قم بإنشاء مشروعك وقم بتثبيت المكتبات المطلوبة:

تحديث APT & تثبيت apt HTUP TMUX

الأشعة فوق البنفسجية init

الأشعة فوق البنفسجية VENV -P 3.12

المصدر .venv/bin/activate

تصدير UV_TORCH_BACKEND=تلقائي

تصدير HF_HUB_ENABLE_HF_TRANSFER="1"

الأشعة فوق البنفسجية PIP تثبيت مجموعات بيانات VLLM BlobFile huggingface_hub hf_transfer

بعد ذلك ، افتح جلسة tmux

2. لبدء استضافة vllm ، ما عليك سوى استخدام vllm serve:

vllm يخدم moonshotai / Kimi-K2-Instruct - الثقة عن بعد - الرمز الترددي - dtype bfloat16 - max-model-len 12000 - max-num-seqs 8 - الكمية = "fp8" - tensor_parallel_size 8

يعد تنزيل نقطة التفتيش الفعلية أمرا صعبا ، لأنه حتى مع hf_transfer سيستغرق الأمر ساعة واحدة (أي شخص يعرف حلا أسرع أو تركيب نقطة تفتيش تم تنزيلها بطريقة ما؟)

3. ثم في جزء tmux جديد ، قم بتثبيت نفق cloudflare السريع وابدأ تشغيله

تثبيت Cloudflared

نفق Cloudflared --URL

هذا هو في الأساس! سيكون الخادم المتوافق مع OpenAI متاحا على عنوان URL الذي يوفره Cloudflare ، في حالتي ، وأنا فقط أستخدم الغلاف البسيط الخاص بي على عميل openai لإنشاء الكثير من البيانات التركيبية من خلاله

38.69K

الأفضل

المُتصدِّرة

التطبيقات المفضلة