Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

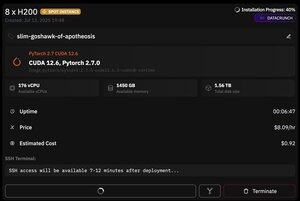

ale co jest świetne w @PrimeIntellect, to dostępność instancji spot -- dzisiaj dostałem węzeł z 8xH200 za zaledwie 8 USD/godz!

Pokażę, jak szybko skonfigurować inferencję moonshotai/Kimi-K2-Instruct używając vllm

1. Po uzyskaniu dostępu SSH do swojego podu (czekaj około 10 minut), stwórz swój projekt i zainstaluj wymagane biblioteki:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Po tym otwórz sesję tmux

2. Aby rozpocząć hostowanie vllm, po prostu użyj vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Pobieranie rzeczywistego punktu kontrolnego jest trudne, ponieważ nawet z hf_transfer zajmie to 1 godzinę (czy ktoś zna szybsze rozwiązanie lub sposób na zamontowanie pobranego punktu kontrolnego w jakiś sposób?)

3. Następnie w nowym oknie tmux zainstaluj cloudflare quick tunnel i uruchom go

install cloudflared

cloudflared tunnel --url

To w zasadzie wszystko! Serwer kompatybilny z OpenAI będzie dostępny pod adresem URL podanym przez Cloudflare, w moim przypadku to jest i po prostu używam mojego prostego wrappera nad klientem openai, aby generować dużo syntetycznych danych przez to.

38,69K

Najlepsze

Ranking

Ulubione