Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

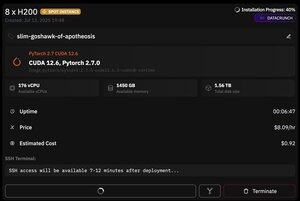

ale co je na @PrimeIntellect skvělé, je dostupnost spotových instancí -- dnes mám uzel s 8xH200 za pouhých 8 $/hod!

Ukážu, jak rychle nastavím inferenci moonshotai/Kimi-K2-Instruct pomocí vllm

1. Po získání přístupu SSH k vašemu podu (počkejte asi 10 minut) vytvořte projekt a nainstalujte požadované knihovny:

aktualizace apt && instalace apt htop tmux

UV inicializace

UV záření -P 3.12

zdroj: .venv/bin/activate

exportovat UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datové sady huggingface_hub hf_transfer

Poté otevřete relaci tmux

2. Chcete-li začít hostovat vllm, jednoduše použijte vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Samotné stažení kontrolního bodu je obtížné, protože i s hf_transfer to zabere 1 hodinu (zná někdo rychlejší řešení nebo nějak připojení staženého kontrolního bodu?)

3. Poté v novém podokně tmux nainstalujte cloudflare quick tunnel a spusťte jej

Instalace cloudflared

cloudflared tunel --url

To je v podstatě vše! Server kompatibilní s OpenAI bude k dispozici na adrese URL poskytnuté Cloudflare, v mém případě je to a já jen používám svůj jednoduchý wrapper přes klienta openai, abych přes něj vygeneroval spoustu syntetických dat

38,68K

Top

Hodnocení

Oblíbené