Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

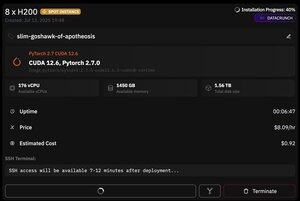

mas o que é ótimo sobre @PrimeIntellect é a disponibilidade de instâncias spot - hoje eu tenho um nó com 8xH200 por apenas US $ 8 / h!

Vou mostrar como configurei rapidamente a inferência moonshotai / Kimi-K2-Instruct usando vllm

1. Depois de obter acesso SSH ao seu pod (aguarde cerca de 10 minutos), crie seu projeto e instale as bibliotecas necessárias:

Atualização do apt && instalação do apt htop tmux

Inicialização UV

uv venv -p 3.12

fonte .venv/bin/activate

exportar UV_TORCH_BACKEND=auto

exportação HF_HUB_ENABLE_HF_TRANSFER="1"

Conjuntos de dados de blobfile de instalação de pip UV huggingface_hub hf_transfer

Depois disso, abra uma sessão tmux

2. Para começar a hospedar o vllm, basta usar o vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

O download real do checkpoint é difícil, pois mesmo com hf_transfer levará 1 hora (alguém conhece uma solução mais rápida ou montar o checkpoint baixado de alguma forma?)

3. Em seguida, em um novo painel tmux, instale o cloudflare quick tunnel e inicie-o

Instale o Cloudflared

túnel cloudflared --url

É basicamente isso! Um servidor compatível com OpenAI estará disponível no URL fornecido pela Cloudflare, no meu caso é e eu apenas uso meu wrapper simples sobre o cliente openai para gerar muitos dados sintéticos por meio dele

38,69K

Melhores

Classificação

Favoritos