Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

KI-Forscher @openai

Jason Wei erneut gepostet

📣 Wir freuen uns, unsere realweltliche Studie über einen LLM-Klinik-Copiloten zu teilen, eine Zusammenarbeit zwischen @OpenAI und @PendaHealth.

Bei 39.849 Live-Patientenbesuchen hatten Kliniker mit KI eine relative Reduktion der diagnostischen Fehler um 16 % und eine Reduktion der Behandlungsfehler um 13 % im Vergleich zu denen ohne. 🧵

258,12K

Jason Wei erneut gepostet

Dies ist mein Vortrag von vor 2 Monaten an der @Cornell

„Wie kann ich meine Leistung steigern?“ Eine naheliegende Antwort ist: „Ich werde einfach ein paar Stunden mehr arbeiten.“ Länger zu arbeiten kann helfen, aber irgendwann stößt man an eine physische Grenze.

Eine bessere Frage ist: „Wie kann ich meine Leistung steigern, ohne den Input so stark zu erhöhen?“ Das ist Hebelwirkung.

Wir hören „Hebel“ so oft, dass seine Bedeutung leicht übersehen wird. Meine persönliche Lieblingskategorisierung von Hebel ist von Naval Ravikant: menschliche Arbeit, Kapital und Code / Medien. Jede dieser Kategorien hat in der Geschichte große Wellen der Vermögensschöpfung ausgelöst.

Sobald jedoch eine Hebelquelle populär wird (denken Sie an YouTube-Kanäle heute im Vergleich zu vor zehn Jahren), komprimiert der Wettbewerb die Marge. Wenn also ein neuer Hebel auftaucht, ist das eine seltene Chance auf überproportionale Gewinne.

In diesem Vortrag beschreibe ich KI als diesen aufkommenden Hebel. Ein KI-Agent kombiniert Arbeitshebel (er arbeitet für Sie und ist genehmigungsfrei) mit Codehebel (Sie können ihn kopieren und einfügen).

Es ist klischeehaft zu sagen, dass KI massives Vermögen schaffen wird. Aber durch diese Hebel-Perspektive können wir den lauten KI-Nachrichtenzyklus konsistent interpretieren und die echten Chancen erkennen.

Danke @unsojo, dass Sie mich eingeladen haben!

402,41K

Neuer Blogbeitrag über die Asymmetrie der Verifikation und das "Gesetz des Verifiers":

Die Asymmetrie der Verifikation – die Idee, dass einige Aufgaben viel einfacher zu verifizieren sind als zu lösen – wird zu einem wichtigen Konzept, da wir RL haben, das endlich allgemein funktioniert.

Große Beispiele für die Asymmetrie der Verifikation sind Dinge wie Sudoku-Rätsel, das Schreiben des Codes für eine Website wie Instagram und BrowseComp-Probleme (es dauert ~100 Websites, um die Antwort zu finden, aber es ist einfach zu verifizieren, sobald man die Antwort hat).

Andere Aufgaben haben eine nahezu Symmetrie der Verifikation, wie das Summieren von zwei 900-stelligen Zahlen oder einige Datenverarbeitungsskripte. Wieder andere Aufgaben sind viel einfacher, um machbare Lösungen vorzuschlagen, als sie zu verifizieren (z. B. das Überprüfen eines langen Aufsatzes oder das Nennen einer neuen Diät wie "nur Bison essen").

Eine wichtige Sache, die man über die Asymmetrie der Verifikation verstehen sollte, ist, dass man die Asymmetrie verbessern kann, indem man im Voraus etwas Arbeit leistet. Zum Beispiel, wenn man den Antwortschlüssel zu einem Mathematikproblem hat oder wenn man Testfälle für ein Leetcode-Problem hat. Dies erhöht erheblich die Menge an Problemen mit wünschenswerter Verifikationsasymmetrie.

Das "Gesetz des Verifiers" besagt, dass die Leichtigkeit, KI zu trainieren, um eine Aufgabe zu lösen, proportional dazu ist, wie verifizierbar die Aufgabe ist. Alle Aufgaben, die lösbar und einfach zu verifizieren sind, werden von KI gelöst. Die Fähigkeit, KI zu trainieren, um eine Aufgabe zu lösen, ist proportional dazu, ob die Aufgabe die folgenden Eigenschaften hat:

1. Objektive Wahrheit: Jeder ist sich einig, was gute Lösungen sind.

2. Schnell zu verifizieren: Jede gegebene Lösung kann in wenigen Sekunden verifiziert werden.

3. Skalierbar zu verifizieren: Viele Lösungen können gleichzeitig verifiziert werden.

4. Geringes Rauschen: Die Verifikation ist so eng wie möglich mit der Lösungsqualität korreliert.

5. Kontinuierliche Belohnung: Es ist einfach, die Güte vieler Lösungen für ein einzelnes Problem zu bewerten.

Eine offensichtliche Veranschaulichung des Gesetzes des Verifiers ist die Tatsache, dass die meisten Benchmarks, die in der KI vorgeschlagen werden, einfach zu verifizieren sind und bisher gelöst wurden. Beachten Sie, dass praktisch alle beliebten Benchmarks der letzten zehn Jahre die Kriterien #1-4 erfüllen; Benchmarks, die die Kriterien #1-4 nicht erfüllen, würden Schwierigkeiten haben, populär zu werden.

Warum ist Verifizierbarkeit so wichtig? Die Menge des Lernens in der KI, die stattfindet, wird maximiert, wenn die oben genannten Kriterien erfüllt sind; man kann viele Gradienten-Schritte machen, bei denen jeder Schritt viel Signal hat. Die Geschwindigkeit der Iteration ist entscheidend – sie ist der Grund, warum der Fortschritt in der digitalen Welt so viel schneller war als der Fortschritt in der physischen Welt.

AlphaEvolve von Google ist eines der größten Beispiele für die Nutzung der Asymmetrie der Verifikation. Es konzentriert sich auf Setups, die alle oben genannten Kriterien erfüllen, und hat zu einer Reihe von Fortschritten in der Mathematik und anderen Bereichen geführt. Anders als das, was wir in der KI in den letzten zwei Jahrzehnten gemacht haben, ist es ein neues Paradigma, bei dem alle Probleme in einem Setting optimiert werden, in dem der Trainingssatz dem Testsatz entspricht.

Die Asymmetrie der Verifikation ist überall und es ist aufregend, sich eine Welt mit gezackter Intelligenz vorzustellen, in der alles, was wir messen können, gelöst wird.

298,77K

gerade ein Hit, ich habe sofort gelesen

Kevin Lu10. Juli, 00:01

Warum Sie aufhören sollten, an RL-Forschung zu arbeiten, und stattdessen an Produkten arbeiten sollten //

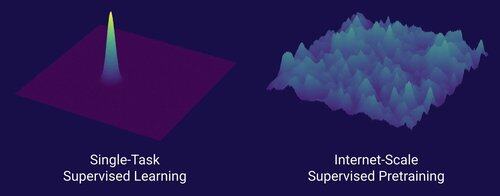

Die Technologie, die den großen Skalierungswechsel in der KI ermöglicht hat, ist das Internet, nicht die Transformer.

Ich denke, es ist allgemein bekannt, dass Daten das Wichtigste in der KI sind und dass Forscher sich trotzdem entscheiden, nicht daran zu arbeiten. ... Was bedeutet es, an Daten (in skalierbarer Weise) zu arbeiten?

Das Internet bot eine reiche Quelle an reichhaltigen Daten, die vielfältig waren, einen natürlichen Lehrplan boten, die Kompetenzen repräsentierten, die den Menschen tatsächlich wichtig sind, und eine wirtschaftlich tragfähige Technologie darstellten, die in großem Maßstab eingesetzt werden konnte – es wurde die perfekte Ergänzung zur Vorhersage des nächsten Tokens und war die Ursuppe, damit die KI abheben konnte.

Ohne Transformer hätten viele Ansätze erfolgreich sein können, wir könnten wahrscheinlich CNNs oder Zustandsraummodelle auf dem Niveau von GPT-4.5 haben. Aber es gab seit GPT-4 keine dramatische Verbesserung der Basismodelle. Denkmodelle sind in engen Bereichen großartig, aber nicht so ein großer Sprung wie GPT-4 im März 2023 (vor über 2 Jahren...)

Wir haben etwas Großartiges mit Reinforcement Learning, aber meine große Angst ist, dass wir die Fehler der Vergangenheit (Ära RL 2015-2020) wiederholen und RL-Forschung betreiben, die nicht relevant ist.

So wie das Internet das Dual von überwachtem Pretraining war, was wird das Dual von RL sein, das zu einem massiven Fortschritt wie von GPT-1 zu GPT-4 führen wird? Ich denke, es sieht nach einer Co-Design-Forschung für Produkte aus.

18,63K

Normale Dating-Ratschläge: Heirate nicht früh, wenn du jedes Jahr viel wächst und dich veränderst.

AI-Kumpel (@YiTayML): Du bist wie ein neuronales Netz, das sich mitten im Training befindet und der Verlust sich noch verbessert. Es ist besser, bis zur Konvergenz zu trainieren, anstatt einen frühen Checkpoint-Snapshot zu machen.

185,81K

Wir haben noch keine KI, die sich selbst verbessert, und wenn wir das tun, wird es ein Wendepunkt sein. Mit mehr Weisheit im Vergleich zu den Tagen von GPT-4 ist es offensichtlich, dass es kein "schneller Start" sein wird, sondern eher extrem allmählich über viele Jahre, wahrscheinlich ein Jahrzehnt.

Das erste, was man wissen sollte, ist, dass Selbstverbesserung, d.h. Modelle, die sich selbst trainieren, nicht binär ist. Betrachten Sie das Szenario, dass GPT-5 GPT-6 trainiert, was unglaublich wäre. Würde GPT-5 plötzlich von der Unfähigkeit, GPT-6 überhaupt zu trainieren, zu einem extrem kompetenten Training übergehen? Definitiv nicht. Die ersten Trainingsläufe von GPT-6 wären wahrscheinlich extrem ineffizient in Bezug auf Zeit und Rechenleistung im Vergleich zu menschlichen Forschern. Und erst nach vielen Versuchen wäre GPT-5 tatsächlich in der Lage, GPT-6 besser als Menschen zu trainieren.

Zweitens, selbst wenn ein Modell sich selbst trainieren könnte, würde es nicht plötzlich in allen Bereichen besser werden. Es gibt einen Gradienten der Schwierigkeit, wie schwer es ist, sich in verschiedenen Bereichen zu verbessern. Zum Beispiel funktioniert Selbstverbesserung vielleicht zunächst nur in Bereichen, die wir bereits wissen, wie man sie nach dem Training leicht behebt, wie grundlegende Halluzinationen oder Stil. Als nächstes kämen Mathematik und Programmierung, was mehr Arbeit erfordert, aber etablierte Methoden zur Verbesserung von Modellen hat. Und dann, am extremen Ende, kann man sich vorstellen, dass es einige Aufgaben gibt, die sehr schwer für die Selbstverbesserung sind. Zum Beispiel die Fähigkeit, Tlingit zu sprechen, eine amerikanische Ureinwohner-Sprache, die von etwa 500 Menschen gesprochen wird. Es wird sehr schwierig für das Modell sein, sich im Sprechen von Tlingit zu verbessern, da wir noch keine Möglichkeiten haben, ressourcenarme Sprachen wie diese zu lösen, außer mehr Daten zu sammeln, was Zeit in Anspruch nehmen würde. Daher wird aufgrund des Gradienten der Schwierigkeit der Selbstverbesserung nicht alles auf einmal geschehen.

Schließlich, vielleicht ist das umstritten, aber letztendlich wird der Fortschritt in der Wissenschaft durch reale Experimente behindert. Einige glauben vielleicht, dass das Lesen aller Biologie-Papiere uns das Heilmittel gegen Krebs verraten würde, oder dass das Lesen aller ML-Papiere und das Beherrschen aller Mathematik es Ihnen ermöglichen würde, GPT-10 perfekt zu trainieren. Wenn dem so wäre, dann wären die Menschen, die die meisten Papiere lesen und die meiste Theorie studieren, die besten KI-Forscher. Aber was wirklich passiert ist, ist, dass KI (und viele andere Bereiche) von rücksichtslos empirischen Forschern dominiert wurde, was widerspiegelt, wie viel Fortschritt auf realen Experimenten basiert, anstatt auf roher Intelligenz. Mein Punkt ist also, dass, obwohl ein superintelligenter Agent 2x oder sogar 5x bessere Experimente als unsere besten menschlichen Forscher entwerfen könnte, er am Ende des Tages immer noch auf die Durchführung der Experimente warten muss, was eine Beschleunigung, aber keinen schnellen Start darstellen würde.

Zusammenfassend gibt es viele Engpässe für den Fortschritt, nicht nur rohe Intelligenz oder ein Selbstverbesserungssystem. KI wird viele Bereiche lösen, aber jeder Bereich hat seine eigene Fortschrittsrate. Und selbst die höchste Intelligenz wird immer noch Experimente in der realen Welt erfordern. Es wird also eine Beschleunigung und kein schneller Start sein, danke, dass Sie meinen Ausbruch gelesen haben.

339,86K

Das Belohnendste an der Arbeit im Büro an Abenden und Wochenenden ist nicht die eigentliche Arbeit, die man erledigt, sondern die spontanen Gespräche mit anderen Menschen, die ebenfalls immer arbeiten. Das sind die Menschen, die dazu neigen, Großes zu erreichen und deine erfolgreichsten Freunde werden.

74,5K

Ich würde sagen, dass wir zweifellos bei AGI sind, wenn KI ein echtes, lebendes Einhorn erschaffen kann. Und nein, ich meine nicht ein Unternehmen im Wert von 1 Milliarde Dollar, ihr Nerds, ich meine ein wörtliches pinkes Pferd mit einem spiralförmigen Horn. Ein Paradebeispiel für wissenschaftlichen Fortschritt in der Gentechnik und Zellprogrammierung. Der Stoff aus Kindheitsträumen. Wage ich zu sagen, dass es in unserem Leben passieren wird.

84,28K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten