Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

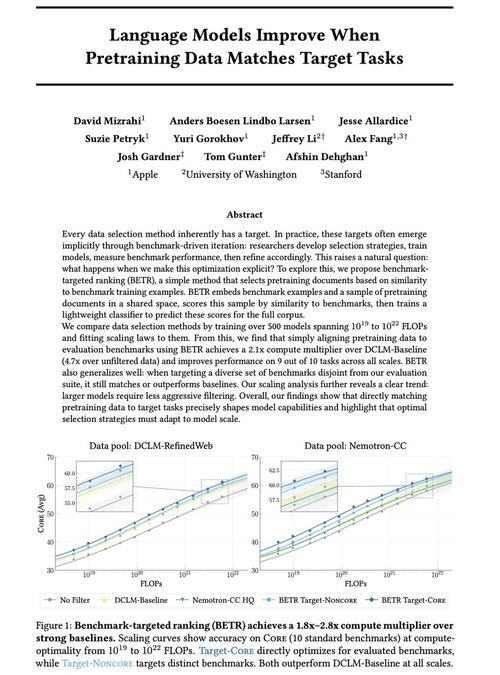

Aufgeregt, unsere neue Arbeit zu teilen: „Sprachmodelle verbessern sich, wenn die Pretraining-Daten mit den Zielaufgaben übereinstimmen“

Ja, es klingt offensichtlich (und das ist es!), aber normalerweise geschieht dies nur implizit und indirekt: intuitiv Daten auswählen → Benchmark → verfeinern → wiederholen.

Wir haben uns gefragt: Was passiert, wenn wir die Pretraining-Daten explizit an Benchmarks anpassen? Das Ergebnis ist ein todsimple Ansatz, der 2x+ Rechenmultiplikatoren gegenüber starken Baselines liefert und uns eine fundierte Möglichkeit gibt, zu untersuchen, wie die Auswahl von Benchmarks die (und einschränkt!) Modellfähigkeiten formt.

Bonus: umfangreiche Skalierungsgesetze aus dem Training von über 500 Modellen, die zeigen, wie sich die optimale Datenauswahl entwickelt, während die Modelle skalieren.

🧵 (1/14)

52,04K

Top

Ranking

Favoriten