Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Atropos v0.3 ist jetzt verfügbar!

Unser RL Environments-Framework hat seit v0.2 viele Verbesserungen erfahren - einige Highlights:

- Atropos kann jetzt von @rogershijin als Benchmarking- und Evaluierungs-Framework verwendet werden, mit unserem ersten externen Benchmark, Reward-Bench 2!

- Hinzugefügt wurde das Reasoning Gym, ein externes Umgebungs-Gym-Repo, das in Atropos portiert wurde und über 100 Denkaufgaben von @neurosp1ke und Freunden enthält.

- @max_paperclips hat das Reasoning Bootcamp von @intern_lm integriert und über 1000 neue Denkaufgaben für RL hinzugefügt.

- @dmayhem93, der leitende Ingenieur von Atropos, hat Dutzende von Bugfixes und andere Verbesserungen der Zuverlässigkeit und Kompatibilität hinzugefügt, bessere Unterstützung für mehrere Umgebungen und CI/CD.

- Viele der Atropos-Hackathon-Umgebungen wurden in /environments/community zusammengeführt - sie alle aufzulisten würde den meisten Platz auf dem Bildschirm einnehmen, aber einige Highlights sind:

VR-CLI von @JakeABoggs, Philosophy RLAIF, Adaptive LLM Teachers, WebVoyager, Protein-Design von @hallerite, eine Modell-Routing-Umgebung von @gabinfay, mehrere auf Lean-Proving, die Catbot-Arena, Pokémon Showdown, Poker, hilfreiche Ärzte, Sanskrit-Poesie von @khoomeik und so viel mehr!

- Weitere bemerkenswerte offiziell unterstützte neue Umgebungen sind:

Antwortformat folgende Umgebung

Pydantic zu JSON-Umgebung, portiert von @MatternJustus' Arbeit

Instruction Following, portiert von @natolambert und @allen_ai's Arbeit

Buchstaben zählen

- 47 brandneue Mitwirkende!

Siehe das vollständige Änderungsprotokoll hier:

18. Juli, 03:22

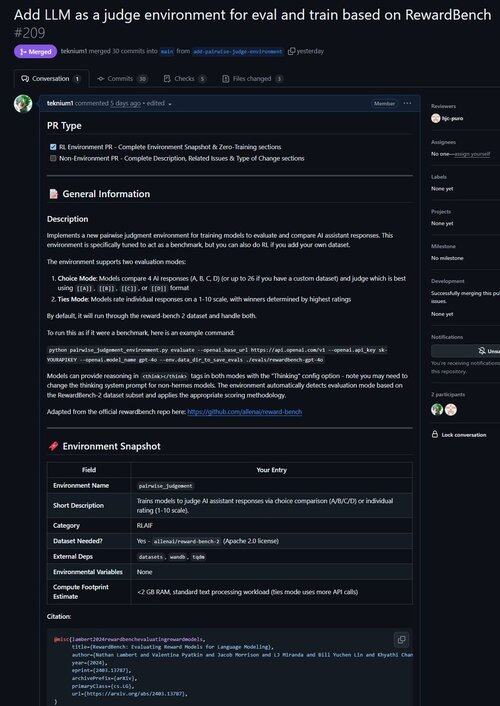

Gerade einen PR für eine Umgebung zusammengeführt, um LLM als Richter zu verbessern und Modelle hinsichtlich ihrer Fähigkeit zur Urteilsfindung zu bewerten!

Wusstest du, dass alle verifizierbaren RL-Umgebungen nahezu äquivalent zu Benchmarks sind (und umgekehrt!)? Daher haben wir einen Evaluierungsbefehl zur Basis von Atropos hinzugefügt, und jetzt kannst du Benchmarks durch Atropos-Umgebungen ausführen.

Wir waren frustriert, mit so vielen veralteten oder unbrauchbaren Benchmark-Frameworks zu arbeiten, also haben wir einen Evaluierungsmodus nur für Atropos, unser RL-Umgebungs-Framework, implementiert.

Unser erster Port von außerhalb unserer bestehenden Umgebungen war @natolambert's Reward-Bench!

Hinweis: Es unterstützt momentan nur generative Belohnungsmodelle (reguläre LLM-Richter).

Sieh dir den PR hier an:

24,86K

Top

Ranking

Favoriten