Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

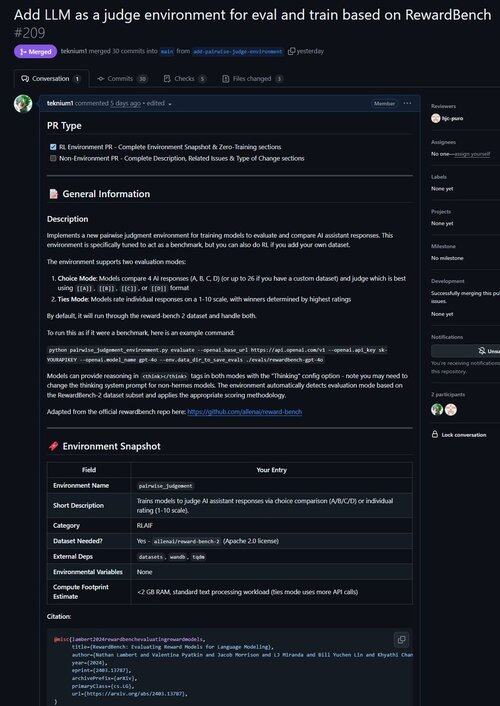

Gerade einen PR für eine Umgebung zusammengeführt, um LLM als Richter zu verbessern und Modelle hinsichtlich ihrer Fähigkeit zur Urteilsfindung zu bewerten!

Wusstest du, dass alle verifizierbaren RL-Umgebungen nahezu äquivalent zu Benchmarks sind (und umgekehrt!)? Daher haben wir einen Evaluierungsbefehl zur Basis von Atropos hinzugefügt, und jetzt kannst du Benchmarks durch Atropos-Umgebungen ausführen.

Wir waren frustriert, mit so vielen veralteten oder unbrauchbaren Benchmark-Frameworks zu arbeiten, also haben wir einen Evaluierungsmodus nur für Atropos, unser RL-Umgebungs-Framework, implementiert.

Unser erster Port von außerhalb unserer bestehenden Umgebungen war @natolambert's Reward-Bench!

Hinweis: Es unterstützt momentan nur generative Belohnungsmodelle (reguläre LLM-Richter).

Sieh dir den PR hier an:

20,54K

Top

Ranking

Favoriten