Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Atropos v0.3 er nå ute!

RL Environments-rammeverket vårt har sett mange oppgraderinger siden v0.2 - noen høydepunkter:

- Atropos kan nå brukes som et benchmarking- og evalueringsrammeverk av @rogershijin, med vår første eksterne benchmark, Reward-Bench 2!

- La til Reasoning Gym, et eksternt treningsstudio som er portert til atropos med over 100 resonneringsoppgaver av @neurosp1ke og venner.

- @max_paperclips integrerte @intern_lm resonnement-bootcamp, og la til 1000+ nye resonneringsoppgaver for RL

- @dmayhem93 hovedingeniøren til Atropos lagt til dusinvis av feilrettinger og andre forbedringer av pålitelighet og kompatibilitet, bedre støtte for multi-miljø og CI/CD

- Mange av Atropos hackathon-miljøene har blitt slått sammen til /environments/community - å liste dem alle ville ta opp mesteparten av skjermplassen, men noen høydepunkter:

VR-CLI av @JakeABoggs, filosofi RLAIF, adaptive LLM-lærere, WebVoyager, proteindesign av @hallerite, et modellrutingsmiljø av @gabinfay, flere på lean-bevis, catbot-arenaen, pokémon-oppgjør, poker, hjelpsomme leger, sanskrit-poesi av @khoomeik og mye mer!

- Andre bemerkelsesverdige offisielt støttede nye miljøer inkluderer:

Svarformat følgende miljø

Pydantisk til JSON-miljø portert fra @MatternJustus arbeid

Instruksjon Følger portert fra @natolambert og @allen_ai arbeid

Brevtelling

- 47 helt nye bidragsytere!

Sjekk ut hele endringsloggen her:

18. juli, 03:22

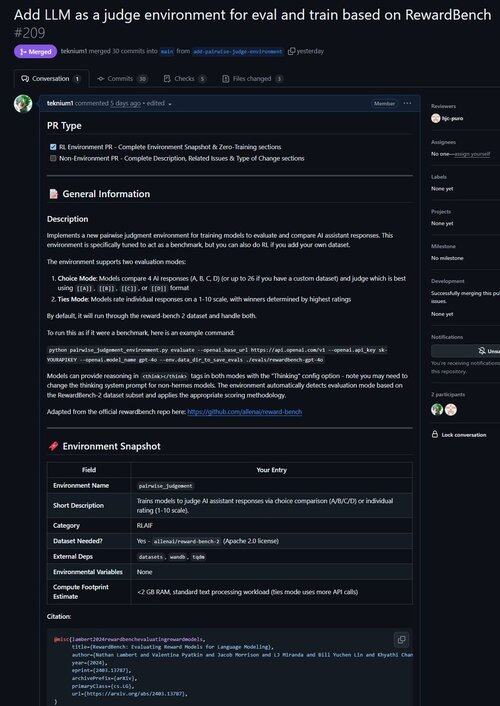

Har nettopp slått sammen en PR for et miljø for å forbedre LLM som dommer, samt evaluere modeller på deres evne til å gjøre vurderinger!

Visste du at alle verifiserbare RL-miljøer er nesten likeverdige med benchmarks (og omvendt!)? Så vi la til en evalueringskommando til Atropos' base, og nå kan du kjøre benchmarks gjennom Atropos-miljøer.

Vi ble frustrerte over å jobbe med så mange benchmark-rammeverk som var utdaterte eller ubrukelige, så vi implementerte kun evalueringsmodus i Atropos, vårt RL-miljørammeverk.

Så vår første havn utenfor våre eksisterende miljøer var @natolambert's Reward-Bench!

Merk: den støtter bare generative belønningsmodeller (vanlige LLM-dommere) for øyeblikket.

Sjekk ut PR her:

24,85K

Topp

Rangering

Favoritter