Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

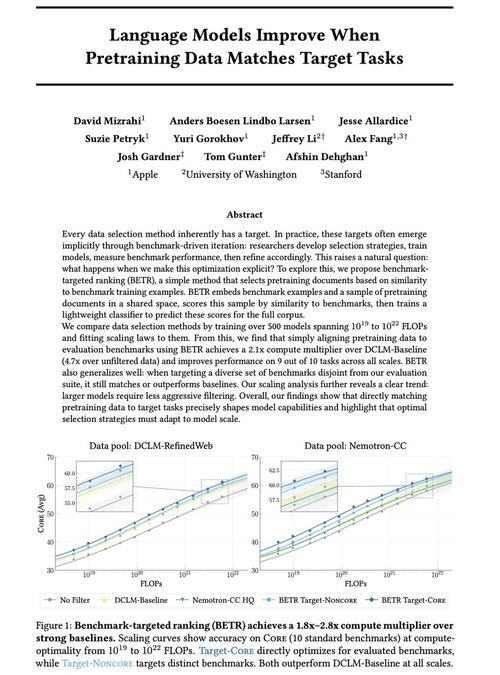

Cieszymy się, że możemy podzielić się naszą nową pracą: „Modele językowe poprawiają się, gdy dane do wstępnego uczenia pasują do docelowych zadań”

Tak, to brzmi oczywiście (i tak jest!), ale zazwyczaj dzieje się to tylko pośrednio i niejawnie: intuicyjnie wybieraj dane → benchmark → udoskonalaj → powtarzaj.

Zastanawialiśmy się: co się stanie, jeśli jawnie dopasujemy dane do wstępnego uczenia do benchmarków? Wynik to bardzo proste podejście, które daje 2x+ mnożniki obliczeniowe w porównaniu do silnych bazowych modeli i daje nam zasadniczy sposób na badanie, jak wybory benchmarków kształtują (i ograniczają!) możliwości modeli.

Bonus: obszerne prawa skalowania z treningu 500+ modeli, które ujawniają, jak optymalny wybór danych ewoluuje w miarę skalowania modeli.

🧵 (1/14)

52,01K

Najlepsze

Ranking

Ulubione