Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

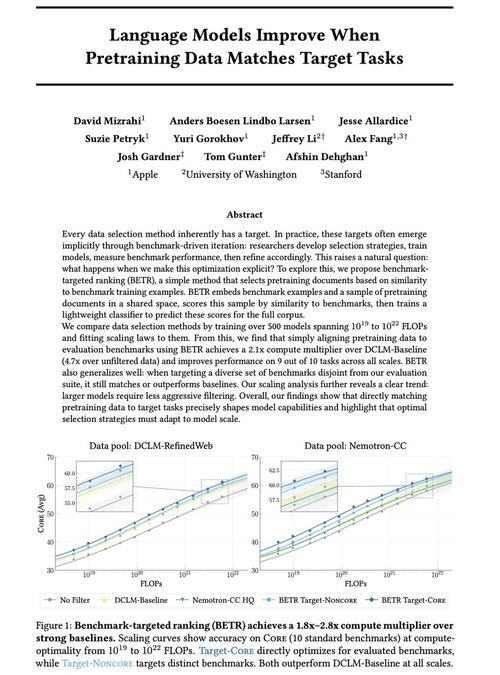

Emocionado de compartir nuestro nuevo trabajo: "Los modelos de lenguaje mejoran cuando los datos de preentrenamiento coinciden con las tareas de destino"

Sí, suena obvio (¡y lo es!), pero normalmente esto solo sucede implícita e indirectamente: seleccione intuitivamente los datos → punto de referencia → refine → repita.

Nos preguntamos: ¿qué sucede si hacemos coincidir explícitamente los datos de preentrenamiento con los puntos de referencia? El resultado es un enfoque muy simple que produce multiplicadores de cómputo 2x + sobre líneas de base sólidas y nos brinda una forma basada en principios de estudiar cómo las opciones de referencia dan forma (¡y restringen!) las capacidades del modelo.

Bono: amplias leyes de escalado del entrenamiento de 500+ modelos que revelan cómo evoluciona la selección óptima de datos a medida que los modelos escalan.

🧵 (1/14)

52.02K

Populares

Ranking

Favoritas