Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

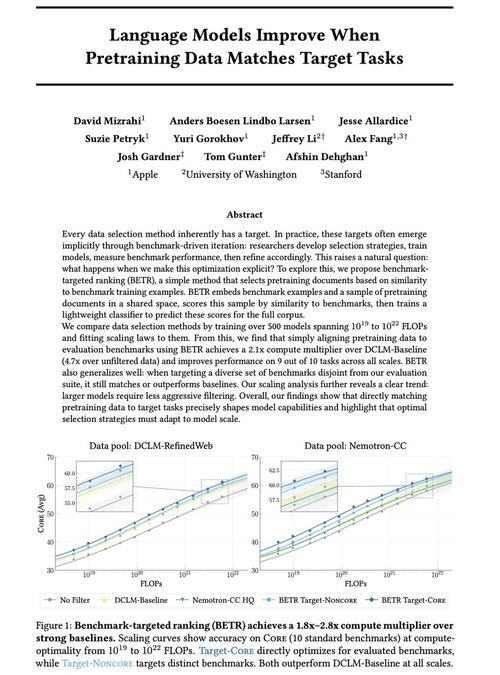

Siamo entusiasti di condividere il nostro nuovo lavoro: “I modelli linguistici migliorano quando i dati di pre-addestramento corrispondono ai compiti target”

Sì, sembra ovvio (e lo è!), ma tipicamente questo avviene solo in modo implicito e indiretto: selezionare intuitivamente i dati → benchmark → affinare → ripetere.

Ci siamo chiesti: cosa succede se abbiniamo esplicitamente i dati di pre-addestramento ai benchmark? Il risultato è un approccio semplicissimo che offre moltiplicatori di calcolo superiori a 2x rispetto a solide baseline e ci fornisce un modo principled per studiare come le scelte dei benchmark plasmino (e vincolino!) le capacità del modello.

Bonus: leggi di scalabilità estensive da 500+ modelli addestrati che rivelano come l'ottimale selezione dei dati evolve man mano che i modelli scalano.

🧵 (1/14)

52,01K

Principali

Ranking

Preferiti