Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

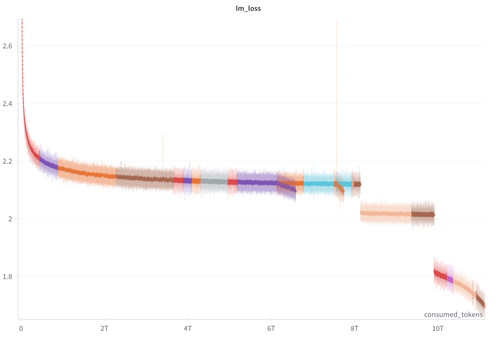

Wir haben gerade über 100 Zwischenprüfungen und unsere Trainingsprotokolle aus dem SmolLM3-3B-Training veröffentlicht.

Wir hoffen, dass dies für Forscher, die an mechanischer Interpretation, Trainingsdynamik, RL und anderen Themen arbeiten, nützlich sein kann :)

Trainingsprotokolle:

-> Üblicher Trainingsverlust (die Lücken im Verlust sind auf Änderungen der Mischung zurückzuführen), grad_norm usw.

-> Metriken pro Schicht/Block (l1/l2-Norm, Mittelwert, Minimum, Maximum, Kurtosis)

Checkpoints:

-> Vortraining alle 40k Schritte (94,4B Tokens)

-> Lange Kontextverlängerung alle 4k Schritte (9,4B Tokens)

-> Nachtraining: SFT, Mid-Training, APO-Suppe, LC-Experte

23,08K

Top

Ranking

Favoriten