Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

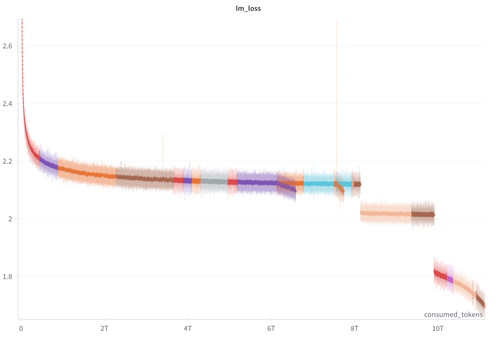

We hebben zojuist 100+ tussenliggende checkpoints en onze trainingslogs van de SmolLM3-3B training vrijgegeven.

We hopen dat dit nuttig kan zijn voor de onderzoekers die werken aan mechanische interpretatie, trainingsdynamiek, RL en andere onderwerpen :)

Trainingslogs:

-> Gewone trainingsverlies (de kloof in het verlies is te wijten aan de verandering van mengsel), grad_norm enz..

-> Per laag/blok metrics (l1/l2 norm, gemiddelde, min, max, kurtosis)

Checkpoints:

-> pre-training elke 40k stap (94,4B tokens)

-> lange contextuitbreiding elke 4k stap (9,4B tokens)

-> post-training: SFT, mid-training, APO soep, LC expert

26,09K

Boven

Positie

Favorieten