Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

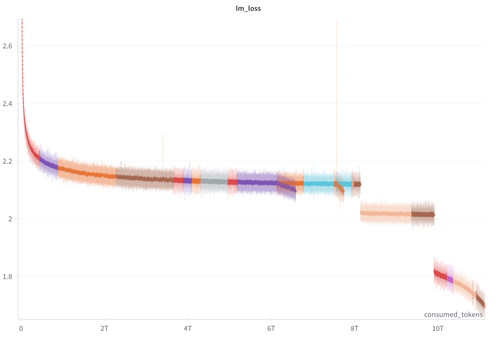

Acabamos de lançar 100+ pontos de verificação intermediários e nossos logs de treinamento do treinamento SmolLM3-3B.

Esperamos que isso possa ser útil para o pesquisador que trabalha com interpretação mecânica, dinâmica de treinamento, RL e outros tópicos :)

Registros de treinamento:

-> Perda de treinamento usual (a lacuna na perda é devido à mudança de mistura), grad_norm ect..

-> Métricas por camada/bloco (norma l1/l2, média, mínimo, máximo, curtose)

Checkpoints:

-> pré-treino a cada passo de 40k (94,4 bilhões de tokens)

-> longa extensão de contexto a cada etapa de 4k (9,4 bilhões de tokens)

-> pós-treino: SFT, meio-treino, sopa APO, especialista LC

30,61K

Melhores

Classificação

Favoritos