トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

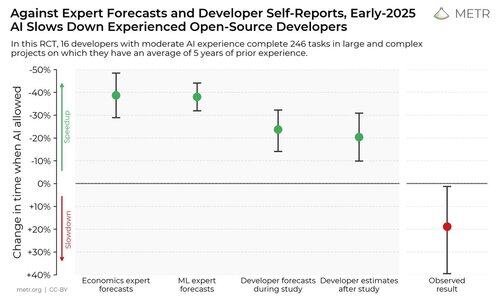

私たちは、AIコーディングツールが経験豊富なオープンソース開発者をどれだけスピードアップするかを確認するために、ランダム化比較試験を実施しました。

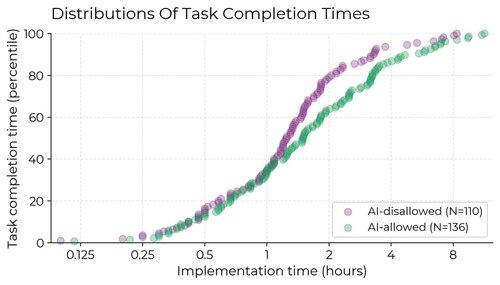

その結果、開発者はAIツールを使用すると20%高速になると思っていましたが、実際にはAIにアクセスできる場合の方がアクセスしていない場合よりも19%遅くなりました。

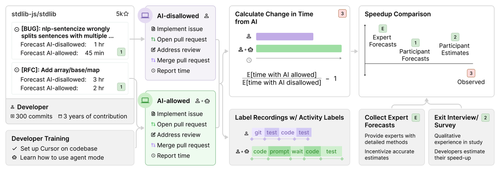

私たちは、16人の経験豊富なオープンソース開発者を募集し、それぞれのリポジトリで246の実際のタスクに取り組みました(平均22k+の星、1M+のコード行)。

各タスクは、AI(通常はCursor Pro w/ Claude 3.5/3.7)を許可するか、AIの助けを許可しないかにランダムに割り当てました。

調査の開始時に、開発者は24%スピードアップすると予測していました。実際に作業を行ってみて、20%のスピードアップがあったと試算しています。しかし、実際には19%も減速していたことが判明しました。

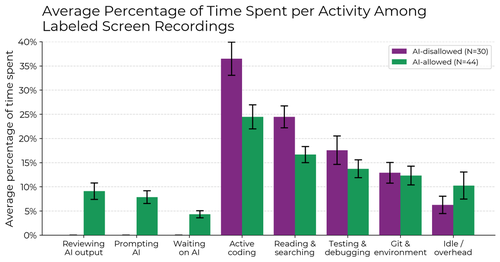

AIが許可されると、開発者は情報を積極的にコーディングして検索する時間を減らし、代わりにAIにプロンプトを立てたり、AIの出力を待ったりレビューしたり、アイドル状態になったりすることに時間を費やすことになります。減速の理由は1つではなく、複数の要因が組み合わさって引き起こされています。

なぜこの研究を実施したのですか?

AIエージェントのベンチマークには、自己完結型であること、アルゴリズムによるスコアリングを使用すること、人間とのライブインタラクションがないという制限があります。これにより、現実世界の影響を直接推測することが難しくなる可能性があります。

AIの研究開発がAI自体によって加速されているのか、それとも自動化されているのかを早期に警告するシステムが必要なら、ベンチマークのようなプロキシや逸話のようなノイズの多い情報に頼るのではなく、実際のエンジニアの試験で直接これを測定できると便利でしょう。

私たちは何を得るのでしょうか?

1. 一部の重要な設定では、最近のAIツールが生産性を向上させていない(むしろ低下している可能性がある)と思われます。

2. スピードアップの自己報告は信頼できない - AIが生産性に与える影響を理解するためには、実際の実験が必要です。

401.33K

トップ

ランキング

お気に入り