Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

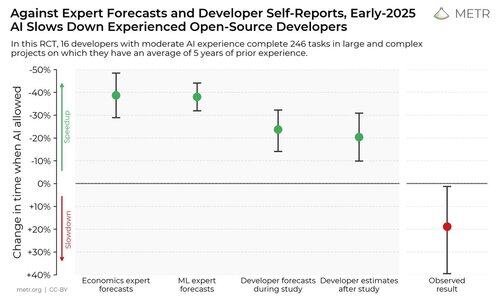

Przeprowadziliśmy randomizowane badanie kontrolne, aby sprawdzić, jak bardzo narzędzia do kodowania AI przyspieszają pracę doświadczonych programistów open-source.

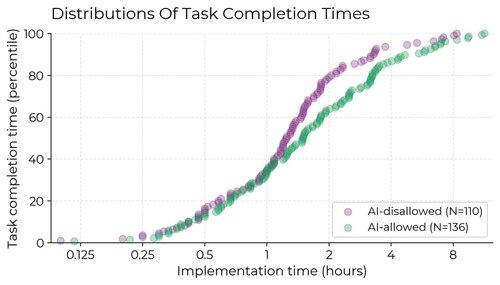

Wyniki nas zaskoczyły: Programiści myśleli, że są o 20% szybszy z narzędziami AI, ale w rzeczywistości byli o 19% wolniejsi, gdy mieli dostęp do AI, niż gdy go nie mieli.

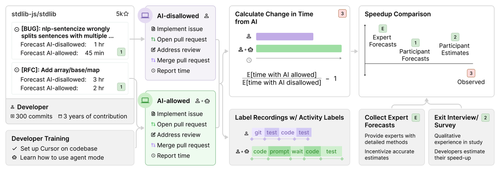

Zrekrutowaliśmy 16 doświadczonych programistów open-source do pracy nad 246 rzeczywistymi zadaniami w ich własnych repozytoriach (średnio 22k+ gwiazdek, 1M+ linii kodu).

Losowo przypisaliśmy każde zadanie, aby pozwolić na pomoc AI (zwykle Cursor Pro z Claude 3.5/3.7) lub zabronić pomocy AI.

Na początku badania deweloperzy prognozowali, że przyspieszą o 24%. Po faktycznym wykonaniu pracy oszacowali, że przyspieszyli o 20%. Okazało się jednak, że w rzeczywistości zostali spowolnieni o 19%.

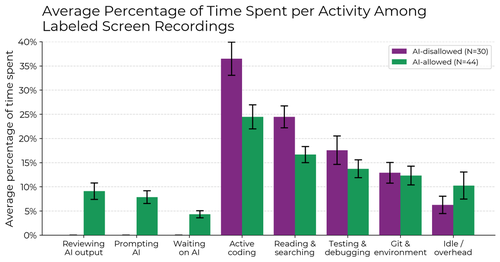

Gdy AI jest dozwolone, deweloperzy spędzają mniej czasu na aktywnym kodowaniu i poszukiwaniu informacji, a zamiast tego poświęcają czas na wywoływanie AI, czekanie na/recenzowanie wyników AI oraz bezczynność. Nie znajdujemy jednego powodu spowolnienia - jest ono spowodowane kombinacją czynników.

Dlaczego przeprowadziliśmy to badanie?

Benchmarki agentów AI mają ograniczenia – są samodzielne, wykorzystują algorytmiczne oceny i brakuje im interakcji z żywymi ludźmi. Może to utrudniać bezpośrednie wnioskowanie o rzeczywistym wpływie.

Jeśli chcemy mieć wczesny system ostrzegawczy, czy badania i rozwój AI są przyspieszane przez samą AI, czy nawet zautomatyzowane, byłoby przydatne, aby móc to bezpośrednio zmierzyć w rzeczywistych próbach inżynieryjnych, zamiast polegać na pośrednich wskaźnikach, takich jak benchmarki, czy nawet głośniejszych informacjach, takich jak anegdoty.

Co możemy wyciągnąć?

1. Wydaje się prawdopodobne, że w przypadku niektórych ważnych ustawień, ostatnie narzędzia AI nie zwiększyły wydajności (a w rzeczywistości mogą ją zmniejszać).

2. Samooceny przyspieszenia są niewiarygodne—aby zrozumieć wpływ AI na wydajność, potrzebujemy eksperymentów w rzeczywistych warunkach.

401,36K

Najlepsze

Ranking

Ulubione