Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vi körde en randomiserad kontrollerad studie för att se hur mycket AI-kodningsverktyg snabbar upp erfarna utvecklare av öppen källkod.

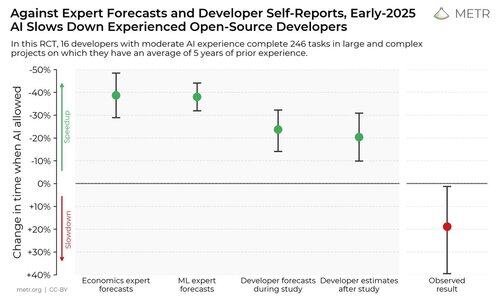

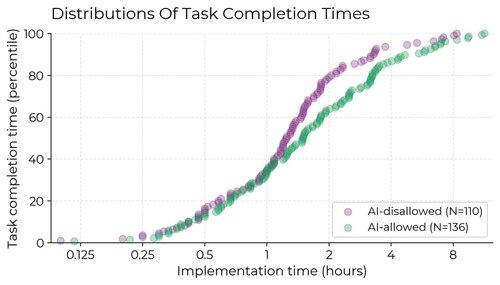

Resultaten överraskade oss: Utvecklare trodde att de var 20 % snabbare med AI-verktyg, men de var faktiskt 19 % långsammare när de hade tillgång till AI än när de inte hade det.

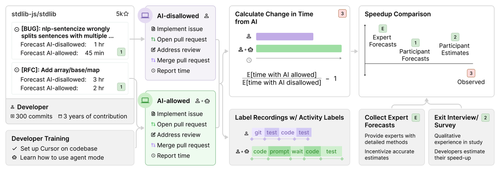

Vi rekryterade 16 erfarna utvecklare av öppen källkod för att arbeta med 246 verkliga uppgifter i sina egna förråd (genomsnitt 22k+ stjärnor, 1M+ rader kod).

Vi tilldelade slumpmässigt varje uppgift för att antingen tillåta AI (vanligtvis Cursor Pro med Claude 3.5/3.7) eller neka AI-hjälp.

I början av studien förutspådde utvecklarna att de skulle öka hastigheten med 24 %. Efter att faktiskt ha utfört arbetet uppskattade de att de hade påskyndats med 20 %. Men det visade sig att de faktiskt saktades ner med 19%.

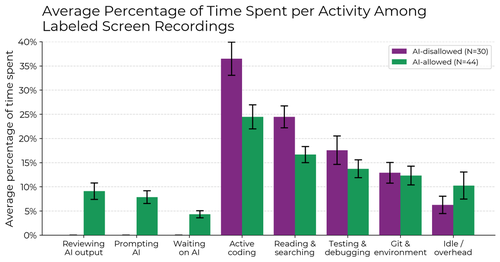

När AI tillåts lägger utvecklare mindre tid på att aktivt koda och söka efter information, och lägger istället tid på att uppmana AI, vänta på/granska AI-utdata och vara inaktiva. Vi hittar ingen enskild orsak till avmattningen – den drivs av en kombination av faktorer.

Varför genomförde vi den här studien?

Benchmarks för AI-agenter har begränsningar – de är fristående, använder algoritmisk bedömning och saknar mänsklig interaktion i realtid. Detta kan göra det svårt att direkt härleda verklig påverkan.

Om vi vill ha ett system för tidig varning för om huruvida AI-forskning och utveckling påskyndas av AI i sig, eller till och med automatiseras, skulle det vara användbart att direkt kunna mäta detta i verkliga ingenjörsförsök, snarare än att förlita sig på proxys som riktmärken eller ännu bullrigare information som anekdoter.

Vad tar vi med oss?

1. Det verkar troligt att för vissa viktiga inställningar har de senaste AI-verktygen inte ökat produktiviteten (och kan faktiskt minska den).

2. Självrapporter om hastighetökning är opålitliga – för att förstå AI:s inverkan på produktiviteten behöver vi experiment i det vilda.

401,37K

Topp

Rankning

Favoriter