Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Noen personlige nyheter: Siden jeg forlot OpenAI, har jeg skrevet offentlig om hvordan jeg kan bygge en AI-fremtid som faktisk er spennende: unngå de verste risikoene og bygge en faktisk god fremtid.

Jeg er glad for å fortsette dette arbeidet som stipendiat ved Roots of Progress Institute.

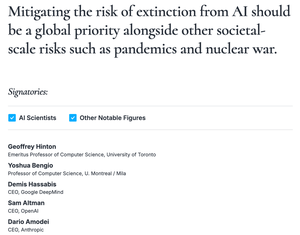

Da jeg forlot OpenAI, skrev jeg at jeg er ganske livredd for hvor AI er på vei. Dette er fortsatt sant, og jeg kjenner så mange AI-laboratorieansatte som vil at alt dette skal stoppe, men føler seg individuelt maktesløse.

Men jeg tror også på en dypt positiv fremtid med AI, hvis risiko håndteres godt.

For å være tydelig, tror jeg AI-laboratoriene i dag er langt ute av sporet for å oppnå en positiv fremtid: De tar ikke AIs risiko seriøst nok, og de legger ikke planer som faktisk er spennende.

En enkel måte å beskrive risikoen på: AI-selskaper kappes om å bygge teknologi som de absolutt ikke forstår og ikke kan kontrollere, men tror kan være ekstremt ødeleggende.

Og når det gjelder fordeler: Å hevde at AI vil løse klimaendringene gjør det ikke slik.

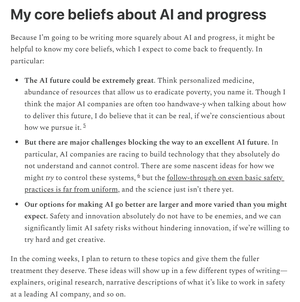

I skrivingen min tar jeg sikte på å gi deg et ærlig, klarsynt syn på hva som skjer innen AI, fra noen som har jobbet i feltet i nesten et tiår nå.

Hvor spiller AI-selskaper ordspill? Hvilke typer risikoreduksjon er enkle? Og hva er jeg så opptatt av egentlig?

Jeg er glad for å bli med i et fellesskap av andre forfattere, men vær trygg på at jeg fortsatt kan si hva jeg vil.

Det er full uavhengighet: Det eneste som bør endres er forhåpentligvis en forbedring av skrivestilen min.

Hvis du vil følge med, kan du abonnere på Clear-Eyed AI på det velkjente andre nettstedet (klikk på det fra biografien min).

Det er gratis; Jeg ber bare om at du deler ordet med andre som kanskje også liker det.

Jeg introduserte meg heller aldri ordentlig der - så dagens innlegg handler om min opprinnelseshistorie om AI-sikkerhet, og noen av kjerneideene som driver tankegangen min.

Også en bonushistorie om det overraskende forholdet mellom AI-sikkerhet og "kinesisk kyllingsalat."

15,99K

Topp

Rangering

Favoritter