Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

489895

Cofundador, CTO-CPO da @SentoraHQ (fmr IntoTheBlock), cofundador da @layerlens_ai, @faktoryai, @neuralfabric e The Sequence AI, Teaching na Columbia-Wharton

489895 republicou

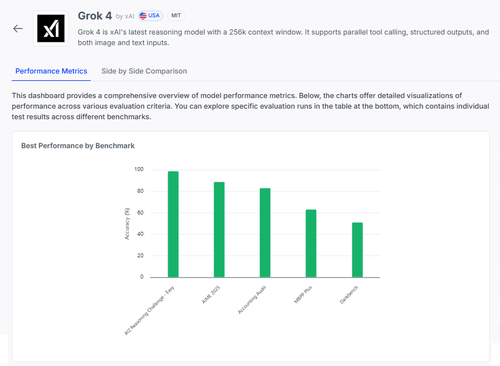

🧠 Grok 4 da @xai está a fazer progressos em benchmarks de raciocínio, mas a situação é mais complexa do que os resultados sugerem.

Aqui está como se compara — e o que realmente podemos aprender com os seus resultados 🧵

📊 Avaliação completa:

1️⃣ Pontuações do Grok 4:

• Desafio de Raciocínio AI2 (Fácil): 98%

• AIME 2025 (Matemática): 89%

• Auditoria Contábil: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Estas são pontuações gerais — mas vamos analisar o que está a funcionar e o que ainda falha.

2️⃣ AIME 2025

✅ Lida bem com álgebra, geometria, teoria dos números

✅ Segue as regras de formatação LaTeX

❌ Tem dificuldades com lógica de múltiplos passos

❌ Erros em combinatória

❌ Problemas de precisão de formato (por exemplo, falta de °)

3️⃣ Auditoria Contábil

✅ Forte em ética e relatórios

✅ Boa compreensão dos princípios de auditoria

❌ Interpreta mal procedimentos semelhantes

❌ Falha em identificar diferenças subtis nas respostas

❌ Dificuldade em aplicar teoria a casos do mundo real

4️⃣ A verdadeira percepção?

Mesmo um modelo com 98% em algumas tarefas pode falhar gravemente sob ambiguidade ou pressão de formatação.

Benchmarks como AIME e Auditoria mostram como ele falha, não apenas quanto pontua.

5️⃣ Por que isso é importante:

Precisamos de uma avaliação transparente, por tarefa — não apenas tabelas de classificação.

#Grok4 é poderoso, mas ainda frágil em domínios do mundo real de alto risco.

🧪 Explore a análise completa:

#AI #LLMs #Benchmarking

1,04K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável