Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

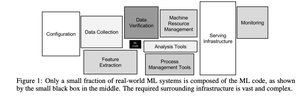

Aquela pequena caixa preta no meio é código de machine learning.

Lembro-me de ter lido o artigo de 2015 da Google sobre a Dívida Técnica Oculta em ML e de pensar em quão pouco de uma aplicação de machine learning era realmente machine learning.

A vasta maioria era infraestrutura, gestão de dados e complexidade operacional.

Com o surgimento da IA, parecia que os grandes modelos de linguagem iriam absorver essas caixas. A promessa era simplicidade: basta inserir um LLM e vê-lo lidar com tudo, desde atendimento ao cliente até geração de código. Sem mais pipelines complexos ou integrações frágeis.

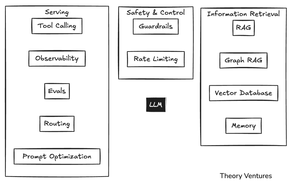

Mas ao construir aplicações internas, observamos uma dinâmica semelhante com a IA.

Os agentes precisam de muito contexto, como um humano: como está estruturado o CRM, o que devemos inserir em cada campo - mas a entrada é cara para o modelo Faminto, Faminto de IA.

Reduzir custos significa escrever software determinístico para substituir o raciocínio da IA.

Por exemplo, automatizar a gestão de e-mails significa escrever ferramentas para criar tarefas no Asana e atualizar o CRM.

À medida que o número de ferramentas aumenta para além de dez ou quinze, a chamada de ferramentas deixa de funcionar. É hora de criar um modelo clássico de machine learning para selecionar ferramentas.

Depois, há a necessidade de observar o sistema, avaliando se ele é eficiente e direcionando para o modelo certo. Além disso, existe toda uma categoria de software para garantir que a IA faça o que se espera dela.

As barreiras evitam respostas inadequadas. A limitação de taxa impede que os custos saiam do controle quando um sistema enlouquece.

A recuperação de informações (RAG - geração aumentada por recuperação) é essencial para qualquer sistema de produção. No meu aplicativo de e-mail, uso um banco de dados vetorial LanceDB para encontrar todos os e-mails de um remetente específico e combinar seu tom.

Existem outras técnicas para gestão do conhecimento em torno do RAG gráfico e bancos de dados vetoriais especializados.

Mais recentemente, a memória tornou-se muito mais importante. As interfaces de linha de comando para ferramentas de IA salvam o histórico de conversas como arquivos markdown.

Quando publico gráficos, quero a legenda da Theory Ventures no canto inferior direito, uma fonte específica, cores e estilos. Agora, tudo isso é salvo dentro de arquivos .gemini ou .claude em uma série de diretórios em cascata.

A simplicidade original dos grandes modelos de linguagem foi absorvida pela complexidade de produção de nível empresarial.

Isso não é idêntico à geração anterior de sistemas de machine learning, mas segue um paralelo claro. O que parecia ser uma simples "caixa mágica de IA" acaba por ser um iceberg, com a maior parte do trabalho de engenharia escondido sob a superfície.

3,68K

Top

Classificação

Favoritos