Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

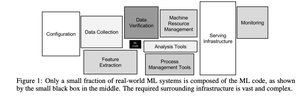

Ten mały czarny pudełko pośrodku to kod uczenia maszynowego.

Pamiętam, jak czytałem artykuł Google’a z 2015 roku na temat ukrytego długu technicznego w ML i myślałem, jak mało aplikacji uczenia maszynowego to tak naprawdę uczenie maszynowe.

Zdecydowana większość to infrastruktura, zarządzanie danymi i złożoność operacyjna.

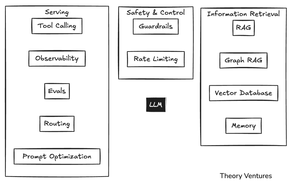

Z nadejściem AI wydawało się, że duże modele językowe pochłoną te pudełka. Obietnica była prosta: wrzuć LLM i obserwuj, jak radzi sobie ze wszystkim, od obsługi klienta po generowanie kodu. Koniec z złożonymi pipeline'ami i kruchymi integracjami.

Jednak przy budowaniu aplikacji wewnętrznych zaobserwowaliśmy podobną dynamikę z AI.

Agenci potrzebują dużo kontekstu, jak człowiek: jak jest zbudowany CRM, co wprowadzamy do każdego pola - ale wprowadzanie danych jest kosztowne dla modelu Hungry, Hungry AI.

Redukcja kosztów oznacza pisanie deterministycznego oprogramowania, aby zastąpić rozumowanie AI.

Na przykład automatyzacja zarządzania e-mailami oznacza pisanie narzędzi do tworzenia zadań w Asanie i aktualizacji CRM.

Gdy liczba narzędzi przekracza dziesięć lub piętnaście, wywoływanie narzędzi przestaje działać. Czas na uruchomienie klasycznego modelu uczenia maszynowego do wyboru narzędzi.

Potem jest obserwacja systemu z widocznością, ocena, czy działa wydajnie, i kierowanie do odpowiedniego modelu. Ponadto istnieje cała kategoria oprogramowania, które zapewnia, że AI robi to, co powinno.

Barierki zapobiegają niewłaściwym odpowiedziom. Ograniczenie liczby zapytań zapobiega niekontrolowanemu wzrostowi kosztów, gdy system szaleje.

Pozyskiwanie informacji (RAG - generacja wzbogacona o pozyskiwanie) jest niezbędne dla każdego systemu produkcyjnego. W mojej aplikacji e-mailowej używam bazy danych wektorowej LanceDB, aby znaleźć wszystkie e-maile od konkretnego nadawcy i dopasować ich ton.

Są inne techniki zarządzania wiedzą związane z grafem RAG i wyspecjalizowanymi bazami danych wektorowych.

Ostatnio pamięć stała się znacznie ważniejsza. Interfejsy wiersza poleceń dla narzędzi AI zapisują historię rozmów jako pliki markdown.

Kiedy publikuję wykresy, chcę, aby podpis Theory Ventures znajdował się w prawym dolnym rogu, z określoną czcionką, kolorami i stylami. Te wszystkie informacje są teraz zapisywane w plikach .gemini lub .claude w serii kaskadowych katalogów.

Oryginalna prostota dużych modeli językowych została pochłonięta przez złożoność produkcyjną na poziomie przedsiębiorstwa.

To nie jest identyczne z poprzednią generacją systemów uczenia maszynowego, ale podąża za wyraźnym paralelem. To, co wydawało się prostym "czarodziejskim pudełkiem AI", okazuje się być górą lodową, z większością pracy inżynieryjnej ukrytą pod powierzchnią.

3,68K

Najlepsze

Ranking

Ulubione