Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Sunt extrem de entuziasmat de potențialul fidelității și interpretabilității lanțului de gândire. A influențat semnificativ designul modelelor noastre de raționament, începând cu previzualizarea o1.

Pe măsură ce sistemele AI cheltuiesc mai mult calcul, de exemplu pe probleme de cercetare pe termen lung, este esențial să avem o modalitate de a monitoriza procesul lor intern. Proprietatea minunată a CoT-urilor ascunse este că, deși încep cu un limbaj pe care îl putem interpreta, procedura de optimizare scalabilă nu este adversă pentru capacitatea observatorului de a verifica intenția modelului - spre deosebire de supravegherea directă cu un model de recompensă.

Tensiunea aici este că, dacă CoT-urile nu au fost ascunse în mod implicit și vedem procesul ca parte a rezultatului AI, există o mulțime de stimulente (și, în unele cazuri, necesitate) pentru a-l supraveghea. Cred că putem lucra pentru ce este mai bun din ambele lumi aici - să ne antrenăm modelele să fie grozave în a-și explica raționamentul intern, dar în același timp să păstrăm capacitatea de a-l verifica ocazional.

Fidelitatea CoT face parte dintr-o direcție mai largă de cercetare, care este antrenarea pentru interpretabilitate: stabilirea obiectivelor într-un mod care să antreneze cel puțin o parte a sistemului să rămână onest și monitorizabil la scară. Continuăm să ne creștem investițiile în această cercetare la OpenAI.

16 iul., 00:09

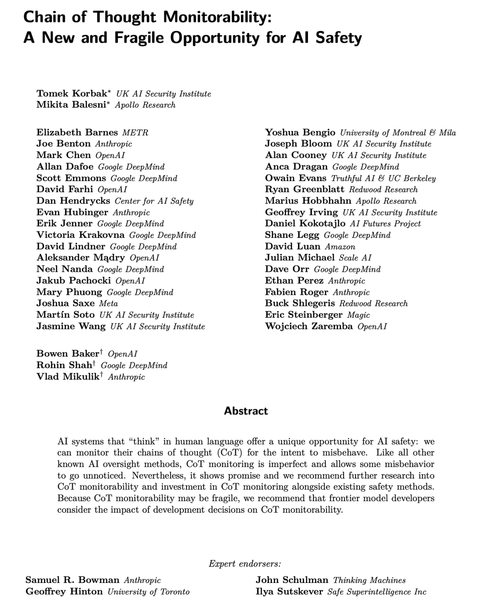

Modelele moderne de raționament gândesc într-o engleză simplă.

Monitorizarea gândurilor lor ar putea fi un instrument puternic, dar fragil, pentru supravegherea viitoarelor sisteme AI.

Eu și cercetătorii din multe organizații credem că ar trebui să lucrăm pentru a evalua, păstra și chiar îmbunătăți monitorizabilitatea CoT.

264,19K

Limită superioară

Clasament

Favorite