Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

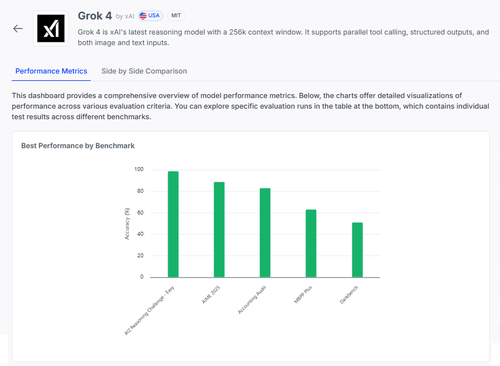

🧠 Grok 4 di @xai sta facendo progressi nei benchmark di ragionamento, ma la situazione è più sfumata di quanto i punteggi suggeriscano.

Ecco come si presenta — e cosa possiamo davvero imparare dai suoi risultati 🧵

📊 Valutazione completa:

1️⃣ Punteggi di Grok 4:

• AI2 Reasoning Challenge (Facile): 98%

• AIME 2025 (Matematica): 89%

• Audit Contabile: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Questi sono punteggi generali — ma concentriamoci su cosa funziona e cosa ancora fallisce.

2️⃣ AIME 2025

✅ Gestisce algebra, geometria, teoria dei numeri

✅ Segue le regole di formattazione LaTeX

❌ Ha difficoltà con la logica a più passaggi

❌ Errori nella combinatoria

❌ Problemi di precisione nel formato (ad es. ° mancante)

3️⃣ Audit Contabile

✅ Forte in etica e reporting

✅ Buona comprensione dei principi di auditing

❌ Malinterpreta procedure simili

❌ Non riesce a individuare sottili differenze nelle risposte

❌ Difficoltà ad applicare la teoria a casi reali

4️⃣ La vera intuizione?

Anche un modello con il 98% in alcuni compiti può fallire duramente sotto ambiguità o stress di formattazione.

I benchmark come AIME e Audit mostrano come fallisce, non solo quanto segna.

5️⃣ Perché questo è importante:

Abbiamo bisogno di una valutazione trasparente, per compito — non solo di classifiche.

#Grok4 è potente, ma ancora fragile in domini reali ad alto rischio.

🧪 Esplora il riepilogo completo:

#AI #LLMs #Benchmarking

1,02K

Principali

Ranking

Preferiti