Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

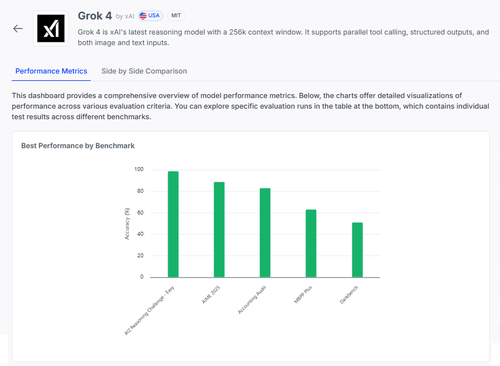

🧠 Grok 4 autorstwa @xai robi postępy w benchmarkach rozumowania, ale obraz jest bardziej złożony, niż sugerują wyniki.

Oto jak się prezentuje — i czego naprawdę możemy się nauczyć z jego wyników 🧵

📊 Pełna ocena:

1️⃣ Wyniki Grok 4:

• AI2 Reasoning Challenge (Łatwy): 98%

• AIME 2025 (Matematyka): 89%

• Audyt Księgowy: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

To są wyniki ogólne — ale przyjrzyjmy się bliżej, co działa, a co nadal zawodzi.

2️⃣ AIME 2025

✅ Radzi sobie z algebrą, geometrią, teorią liczb

✅ Przestrzega zasad formatowania LaTeX

❌ Ma problemy z logiką wieloetapową

❌ Błędy w kombinatoryce

❌ Problemy z precyzją formatu (np. brak °)

3️⃣ Audyt Księgowy

✅ Silny w etyce i raportowaniu

✅ Dobrze rozumie zasady audytu

❌ Błędnie interpretuje podobne procedury

❌ Nie dostrzega subtelnych różnic w odpowiedziach

❌ Ma trudności z zastosowaniem teorii w rzeczywistych przypadkach

4️⃣ Prawdziwy wgląd?

Nawet model z wynikiem 98% w niektórych zadaniach może mocno zawieść w sytuacjach niejednoznacznych lub pod presją formatowania.

Benchmarki takie jak AIME i Audyt pokazują, jak zawodzi, a nie tylko jak dużo zdobywa punktów.

5️⃣ Dlaczego to ma znaczenie:

Potrzebujemy przejrzystej oceny per zadanie — nie tylko rankingów.

#Grok4 jest potężny, ale nadal kruchy w krytycznych, rzeczywistych dziedzinach.

🧪 Zbadaj pełne zestawienie:

#AI #LLMs #Benchmarking

1,02K

Najlepsze

Ranking

Ulubione