Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🧠 Grok 4 de @xai face pași în reperele de raționament, dar imaginea este mai nuanțată decât sugerează scorurile.

Iată cum se compară și ce putem învăța cu adevărat din rezultatele 🧵 sale

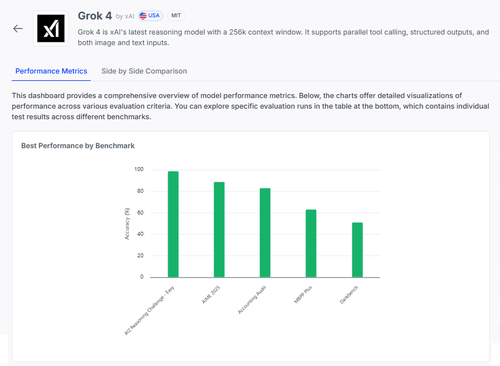

📊 Evaluare completă:

1️⃣ Scoruri Grok 4:

• Provocarea raționamentului AI2 (ușor): 98%

• AIME 2025 (matematică): 89%

• Audit contabil: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Acestea sunt scoruri de top - dar să mărim ce funcționează și ce încă eșuează.

2️⃣ AIME 2025

✅ Se ocupă de algebră, geometrie, teoria numerelor

✅ Respectă regulile de formatare LaTeX

❌ Se luptă cu logica în mai mulți pași

❌ Erori în combinatorică

❌ Probleme de precizie a formatului (de exemplu, lipsă °)

3️⃣ Audit contabil

✅ Puternic în etică și raportare

✅ Înțelegere solidă a principiilor de audit

❌ Interpretează greșit proceduri similare

❌ Nu reușește să identifice diferențele subtile de răspuns

❌ Sunt greu să aplicăm teoria la cazuri din lumea reală

4️⃣ Adevărata perspectivă?

Chiar și un model cu 98% pe unele sarcini poate eșua greu din cauza ambiguității sau a stresului de formatare.

Benchmark-uri precum AIME și Audit arată cum eșuează, nu doar cât de mult punctează.

5️⃣ De ce contează acest lucru:

Avem nevoie de o evaluare transparentă, pe sarcină - nu doar de clasamente.

#Grok4 este puternică, dar totuși fragilă în domenii cu mize mari, din lumea reală.

🧪 Explorați defalcarea completă:

#AI #LLMs #Benchmarking

1,06K

Limită superioară

Clasament

Favorite