Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🧠 Grok 4 by @xai робить успіхи в орієнтирах міркувань, але картина більш нюансована, ніж припускають оцінки.

Ось як він складається — і чого ми насправді можемо навчитися з його результатів 🧵

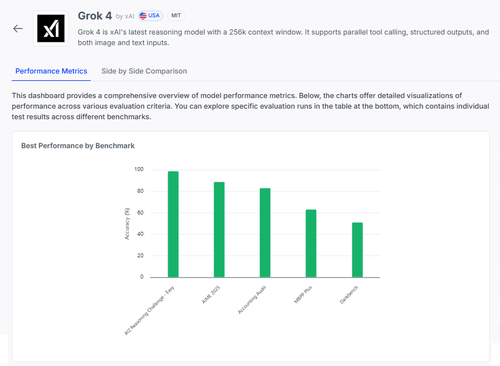

📊 Повний евал:

1️⃣ Grok 4 бали:

• Завдання на міркування AI2 (легкий): 98%

• AIME 2025 (математика): 89%

• Бухгалтерський аудит: 84%

• ММЛУ-Плюс: 64%

• Data4Health: 55%

Це найвищі показники, але давайте розглянемо, що працює, а що все ще не працює.

2️⃣ AIME 2025

✅ Займається алгеброю, геометрією, теорією чисел

✅ Дотримується правил форматування LaTeX

❌ Бореться з багатоступінчастою логікою

❌ Помилки в комбінаториці

❌ Проблеми з точністю форматування (наприклад, відсутній °)

3️⃣ Бухгалтерський аудит

✅ Сильні показники етики та звітності

✅ Глибоке розуміння принципів аудиту

❌ Неправильно тлумачить аналогічні процедури

❌ Не помічає тонких відмінностей у відповідях

❌ Важке застосування теорії до реальних випадків

4️⃣ Справжнє прозріння?

Навіть модель з 98% на деяких завданнях може сильно вийти з ладу в умовах неоднозначності або стресу форматування.

Такі тести, як AIME та Audit, показують, як він зазнає невдачі, а не лише скільки він набирає балів.

5️⃣ Чому це важливо:

Нам потрібне прозоре оцінювання за завданнями, а не лише таблиці лідерів.

#Grok4 потужний, але все ще крихкий у реальних доменах з високими ставками.

🧪 Ознайомтеся з повною розбивкою:

#AI #LLMs #Benchmarking

1,02K

Найкращі

Рейтинг

Вибране