Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

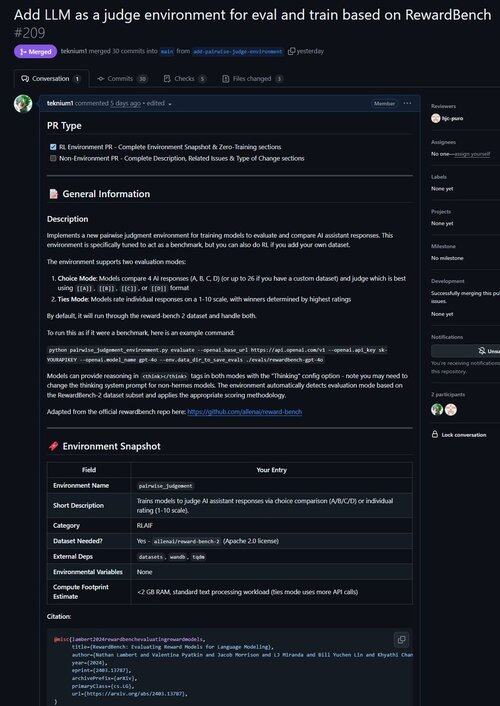

Har nettopp slått sammen en PR for et miljø for å forbedre LLM som dommer, samt evaluere modeller på deres evne til å gjøre vurderinger!

Visste du at alle verifiserbare RL-miljøer er nesten likeverdige med benchmarks (og omvendt!)? Så vi la til en evalueringskommando til Atropos' base, og nå kan du kjøre benchmarks gjennom Atropos-miljøer.

Vi ble frustrerte over å jobbe med så mange benchmark-rammeverk som var utdaterte eller ubrukelige, så vi implementerte kun evalueringsmodus i Atropos, vårt RL-miljørammeverk.

Så vår første havn utenfor våre eksisterende miljøer var @natolambert's Reward-Bench!

Merk: den støtter bare generative belønningsmodeller (vanlige LLM-dommere) for øyeblikket.

Sjekk ut PR her:

20,53K

Topp

Rangering

Favoritter