Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

To było takie zabawne, Mario. Dziękuję, że zaprosiłeś mnie do programu, aby porozmawiać o wszystkim, co dzieje się na rynku!

Mario Gabriele 🦊22 lip, 20:22

Nasz najnowszy odcinek z Tomaszem Tunguzem jest już dostępny!

Dekada Danych

@ttunguz spędził prawie dwie dekady, przekształcając dane w spostrzeżenia inwestycyjne. Po wsparciu Looker, Expensify i Monte Carlo w Redpoint Ventures, w 2022 roku uruchomił @Theoryvc z odważną wizją: stworzyć "korporację inwestycyjną", w której badacze, inżynierowie i operatorzy pracują obok inwestorów, tworząc mapy rynkowe w czasie rzeczywistym i narzędzia AI wewnętrzne. Jego debiutancki fundusz zamknął się na kwotę 238 milionów dolarów, a zaledwie 19 miesięcy później zamknął drugi fundusz na 450 milionów dolarów. Skoncentrowany na danych, AI i infrastrukturze kryptowalut, Theory działa w sercu dzisiejszych najważniejszych zmian technologicznych. Badamy, jak dane przekształcają kapitał venture, dlaczego tradycyjne modele inwestycyjne są zakłócane i co jest potrzebne, aby zbudować firmę, która nie tylko przewiduje przyszłość, ale aktywnie pomaga ją tworzyć.

Słuchaj teraz:

• YouTube:

• Spotify:

• Apple:

Wielkie podziękowania dla niesamowitych sponsorów, którzy sprawiają, że podcast jest możliwy:

✨ Brex — Rozwiązanie bankowe dla startupów:

✨ Generalist+ — Kluczowa inteligencja dla nowoczesnych inwestorów i technologów:

Badamy:

→ Jak działa model "korporacji inwestycyjnej" Theory

→ Dlaczego giełdy kryptowalut mogą stworzyć realną ścieżkę do rynków publicznych dla małych firm programistycznych

→ Nadchodzący kryzys energetyczny — dlaczego centra danych mogą konsumować 15% energii elektrycznej w USA w ciągu pięciu lat

→ Szybki wzrost stablecoinów, gdy główne banki kierują przez nie 5-10% dolarów amerykańskich

→ Dlaczego Ethereum stoi przed egzystencjalnym wyzwaniem podobnym do AWS tracącego grunt na rzecz Azure w erze AI

→ Dlaczego Tomasz wierzy, że dzisiejsza garstka agentów stanie się 100+ cyfrowymi współpracownikami do końca roku

→ Dlaczego Meta stawia miliardy na okulary AR, aby zmienić sposób, w jaki wchodzimy w interakcje z maszynami

→ Jak Theory Ventures wykorzystuje AI do przyspieszania badań rynkowych, analizy transakcji i podejmowania decyzji inwestycyjnych

…I wiele więcej!

7,63K

OpenAI otrzymuje średnio 1 zapytanie na Amerykanina dziennie.

Google otrzymuje około 4 zapytań na Amerykanina dziennie.

Od tego czasu 50% zapytań w wyszukiwarce Google ma AI Overviews, co oznacza, że co najmniej 60% wyszukiwań w USA to teraz AI.

Zajęło to trochę więcej czasu, niż się spodziewałem, aby to się wydarzyło. W 2024 roku przewidywałem, że 50% wyszukiwań konsumenckich będzie wspieranych przez AI. (

Ale AI już dotarło do wyszukiwania.

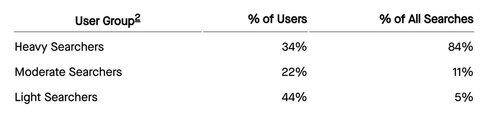

Jeśli wzorce wyszukiwania Google są jakimkolwiek wskaźnikiem, istnieje prawo potęgowe w zachowaniu wyszukiwania. Analiza zachowań wyszukiwania Google przez SparkToro pokazuje, że górna jedna trzecia Amerykanów, którzy wyszukują, wykonuje ponad 80% wszystkich wyszukiwań - co oznacza, że użycie AI nie jest prawdopodobnie równomiernie rozłożone - jak przyszłość.

Strony internetowe i firmy zaczynają odczuwać skutki tego. Artykuł The Economist „AI zabija internet. Czy coś może go uratować?” uchwyca zeitgeist w nagłówku. (

Superwiększość Amerykanów teraz wyszukuje z AI. Drugorzędne skutki zmieniających się wzorców wyszukiwania nadchodzą w drugiej połowie tego roku i więcej osób będzie pytać: „Co się stało z moim ruchem?” (

AI to nowy kanał dystrybucji, a ci, którzy go wykorzystają, zyskają udział w rynku.

- William Gibson widział znacznie dalej w przyszłość!

- To jest oparte na analizie punktu środkowego wykresu SparkToro, jest to bardzo prosta analiza i ma pewne błędy w wyniku.

8,51K

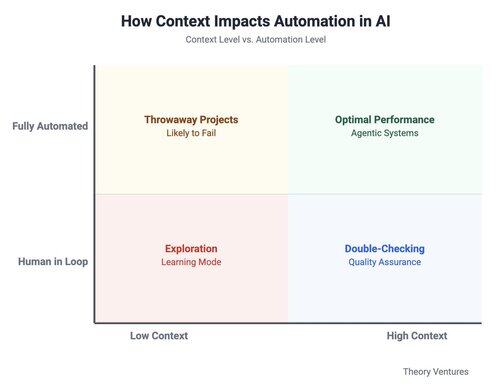

Pracując z AI, zatrzymuję się przed wpisaniem czegokolwiek do pola, aby zadać sobie pytanie: czego oczekuję od AI?

2x2 do ratunku! W którym pudełku jestem?

Na jednej osi, ile kontekstu dostarczam: niewiele do całkiem sporo. Na drugiej, czy powinienem obserwować AI, czy pozwolić mu działać.

Jeśli dostarczam bardzo mało informacji i pozwalam systemowi działać: 'zbadaj trendy inżynierów wdrożonych na miejscu', otrzymuję nieprzydatne wyniki: ogólne przeglądy bez istotnych szczegółów.

Prowadzenie tego samego projektu z serią krótkich pytań prowadzi do iteracyjnej rozmowy, która odnosi sukces - eksploracji.

„Które firmy wdrożyły inżynierów wdrożonych na miejscu (FDE)? Jakie są typowe tła FDE? Jakie typy struktur umów i biznesów nadają się do tej pracy?”

Kiedy mam bardzo niską tolerancję na błędy, dostarczam obszerny kontekst i pracuję iteracyjnie z AI. W przypadku postów na bloga lub analizy finansowej dzielę się wszystkim (aktualnymi szkicami, wcześniejszymi tekstami, szczegółowymi wymaganiami), a następnie postępuję zdanie po zdaniu.

Pozwolenie agentowi na swobodne działanie wymaga zdefiniowania wszystkiego z góry. Rzadko odnoszę tu sukces, ponieważ praca wstępna wymaga ogromnej klarowności - dokładnych celów, kompleksowych informacji i szczegółowych list zadań z kryteriami walidacji - zarysu.

Te podpowiedzi kończą się wyglądaniem jak dokumenty wymagań produktowych, które pisałem jako menedżer produktu.

Odpowiedź na pytanie 'czego oczekuję?' stanie się łatwiejsza, gdy systemy AI uzyskają dostęp do większej ilości moich informacji i poprawią się w wyborze istotnych danych. Gdy będę lepszy w artykułowaniu tego, czego naprawdę chcę, współpraca się poprawi.

Mam na celu przeniesienie znacznie większej liczby moich pytań z lewego górnego pudełka - jak byłem szkolony z Google Search - do pozostałych trzech kwadrantów.

Oczekuję również, że ten nawyk pomoże mi lepiej współpracować z ludźmi.

2,88K

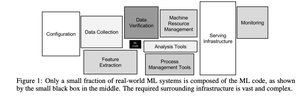

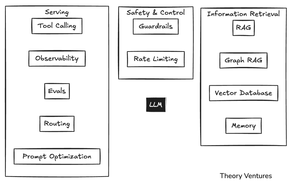

Ten mały czarny pudełko pośrodku to kod uczenia maszynowego.

Pamiętam, jak czytałem artykuł Google’a z 2015 roku na temat ukrytego długu technicznego w ML i myślałem, jak mało aplikacji uczenia maszynowego to tak naprawdę uczenie maszynowe.

Zdecydowana większość to infrastruktura, zarządzanie danymi i złożoność operacyjna.

Z nadejściem AI wydawało się, że duże modele językowe pochłoną te pudełka. Obietnica była prosta: wrzuć LLM i obserwuj, jak radzi sobie ze wszystkim, od obsługi klienta po generowanie kodu. Koniec z złożonymi pipeline'ami i kruchymi integracjami.

Jednak przy budowaniu aplikacji wewnętrznych zaobserwowaliśmy podobną dynamikę z AI.

Agenci potrzebują dużo kontekstu, jak człowiek: jak jest zbudowany CRM, co wprowadzamy do każdego pola - ale wprowadzanie danych jest kosztowne dla modelu Hungry, Hungry AI.

Redukcja kosztów oznacza pisanie deterministycznego oprogramowania, aby zastąpić rozumowanie AI.

Na przykład automatyzacja zarządzania e-mailami oznacza pisanie narzędzi do tworzenia zadań w Asanie i aktualizacji CRM.

Gdy liczba narzędzi przekracza dziesięć lub piętnaście, wywoływanie narzędzi przestaje działać. Czas na uruchomienie klasycznego modelu uczenia maszynowego do wyboru narzędzi.

Potem jest obserwacja systemu z widocznością, ocena, czy działa wydajnie, i kierowanie do odpowiedniego modelu. Ponadto istnieje cała kategoria oprogramowania, które zapewnia, że AI robi to, co powinno.

Barierki zapobiegają niewłaściwym odpowiedziom. Ograniczenie liczby zapytań zapobiega niekontrolowanemu wzrostowi kosztów, gdy system szaleje.

Pozyskiwanie informacji (RAG - generacja wzbogacona o pozyskiwanie) jest niezbędne dla każdego systemu produkcyjnego. W mojej aplikacji e-mailowej używam bazy danych wektorowej LanceDB, aby znaleźć wszystkie e-maile od konkretnego nadawcy i dopasować ich ton.

Są inne techniki zarządzania wiedzą związane z grafem RAG i wyspecjalizowanymi bazami danych wektorowych.

Ostatnio pamięć stała się znacznie ważniejsza. Interfejsy wiersza poleceń dla narzędzi AI zapisują historię rozmów jako pliki markdown.

Kiedy publikuję wykresy, chcę, aby podpis Theory Ventures znajdował się w prawym dolnym rogu, z określoną czcionką, kolorami i stylami. Te wszystkie informacje są teraz zapisywane w plikach .gemini lub .claude w serii kaskadowych katalogów.

Oryginalna prostota dużych modeli językowych została pochłonięta przez złożoność produkcyjną na poziomie przedsiębiorstwa.

To nie jest identyczne z poprzednią generacją systemów uczenia maszynowego, ale podąża za wyraźnym paralelem. To, co wydawało się prostym "czarodziejskim pudełkiem AI", okazuje się być górą lodową, z większością pracy inżynieryjnej ukrytą pod powierzchnią.

3,62K

Jeśli 2025 rok będzie rokiem agentów, to 2026 z pewnością będzie należał do menedżerów agentów.

Menedżerowie agentów to osoby, które mogą zarządzać zespołami agentów AI. Ile agentów jedna osoba może skutecznie zarządzać?

Ledwo mogę zarządzać 4 agentami AI jednocześnie. Proszą o wyjaśnienia, żądają pozwolenia, przeprowadzają wyszukiwania w sieci - wszystko to wymaga mojej uwagi. Czasami zadanie zajmuje 30 sekund. Innym razem 30 minut. Tracę rachubę, który agent co robi, a połowa pracy jest wyrzucana, ponieważ źle interpretują instrukcje.

To nie jest problem umiejętności. To problem narzędzi.

Fizyczne roboty oferują wskazówki dotyczące produktywności menedżerów robotów. MIT opublikowało analizę w 2020 roku, która sugerowała, że przeciętny robot zastępuje 3,3 ludzkich miejsc pracy. W 2024 roku Amazon poinformował, że roboty do pakowania i wysyłki zastąpiły 24 pracowników.

Ale jest jedna kluczowa różnica: AI jest niedeterministyczne. Agenci AI interpretują instrukcje. Improwizują. Czasami całkowicie ignorują polecenia. Roomba może tylko marzyć o kreatywnej wolności, by zignorować Twój salon i zdecydować, że garaż wymaga uwagi.

Teoria zarządzania często kieruje zespoły do zakresu kontroli wynoszącego 7 osób.

Rozmawiając z lepszymi menedżerami agentów, dowiedziałem się, że używają skrzynki odbiorczej agentów, narzędzia do zarządzania projektami do zlecania pracy AI i jej oceny. W inżynierii oprogramowania, pull requesty Githuba lub bilety Linear służą temu celowi.

Bardzo produktywni inżynierowie oprogramowania AI zarządzają 10-15 agentami, precyzując 10-15 zadań w szczegółach, wysyłając je do AI, czekając na zakończenie i następnie przeglądając pracę. Połowa pracy jest wyrzucana i rozpoczynana na nowo z poprawionym poleceniem.

Skrzynka odbiorcza agentów nie jest popularna - jeszcze. Nie jest szeroko dostępna.

Ale podejrzewam, że stanie się niezbędną częścią stosu produktywności dla przyszłych menedżerów agentów, ponieważ to jedyny sposób, aby śledzić pracę, która może napływać w dowolnym momencie.

Jeśli ARR na pracownika jest nową metryką próżności dla startupów, to liczba agentów zarządzanych na osobę może stać się metryką produktywności pracownika.

Ile agentów myślisz, że mógłbyś zarządzać w ciągu 12 miesięcy? 10? 50? 100? Czy mógłbyś zarządzać agentem, który zarządza innymi agentami?

7,83K

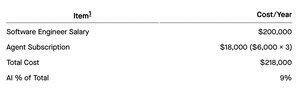

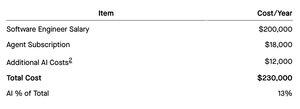

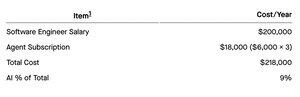

Przez ostatnią dekadę największą pozycją w budżecie R&D każdego startupu była przewidywalna kadra. Ale AI wkracza na rachunek zysków i strat.

Ile powinien wydać startup na AI jako procent swoich wydatków na badania i rozwój?

10%? 30%? 60%?

Są trzy czynniki do rozważenia. Po pierwsze, średnia pensja inżyniera oprogramowania w Dolinie Krzemowej. Po drugie, całkowity koszt AI używanego przez tego inżyniera. Cursor kosztuje teraz 200 dolarów miesięcznie za ich Ultra Plan, a recenzje Devin sugerują 500 dolarów miesięcznie. Po trzecie, liczba agentów, którymi może zarządzać inżynier.

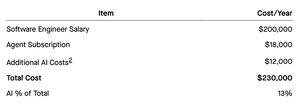

Pierwsze podejście: (pierwszy obrazek)

Ale koszty subskrypcji są prawdopodobnie niskie. Przez ostatnie kilka dni intensywnie bawiłem się agentami kodowania AI i w ciągu pięciu dni uzbierałem rachunek na 1000 dolarów! 😳😅

Więc zaktualizujmy tabelę i załóżmy dodatkowe 1000 dolarów miesięcznie na inżyniera.

Dla typowego startupu szacunkowo 10 do 15% całkowitych wydatków na R&D może być obecnie przeznaczone na AI.

W praktyce warianty będą znacznie szersze, gdy wszyscy nauczymy się lepiej korzystać z AI i przeniknie on do większej części organizacji. Mniejsze firmy, które od początku są natywne w AI, prawdopodobnie będą miały znacznie wyższe wskaźniki.

Jeśli jesteś zainteresowany udziałem w anonimowej ankiecie, opublikuję wyniki, jeśli liczba próbek będzie wystarczająco duża, aby uzyskać statystycznie istotny wynik.

Ankieta jest tutaj:

To jest mocno uproszczony model, w którym przeglądamy tylko pensje, nie uwzględniając świadczeń, sprzętu, infrastruktury deweloperskiej i testowej itp.

To jest szacunkowe oparte na zniżonej osobistej doświadczeniu w kodowaniu.

1,93K

Przez ostatnią dekadę największą pozycją w budżecie R&D każdego startupu była przewidywalna kadra. Ale AI wkracza na rachunek zysków i strat.

Ile powinien wydać startup na AI jako procent swoich wydatków na badania i rozwój?

10%? 30%? 60%?

Są trzy czynniki do rozważenia. Po pierwsze, średnia pensja inżyniera oprogramowania w Dolinie Krzemowej. Po drugie, całkowity koszt AI używanego przez tego inżyniera. Cursor kosztuje teraz 200 dolarów miesięcznie za ich Ultra Plan, a recenzje Devin sugerują 500 dolarów miesięcznie. Po trzecie, liczba agentów, którymi może zarządzać inżynier.

Pierwsze podejście: (pierwszy obrazek)

Ale koszty subskrypcji są prawdopodobnie niskie. Przez ostatnie kilka dni intensywnie bawiłem się agentami kodowania AI i w ciągu pięciu dni uzbierałem rachunek na 1000 dolarów! 😳😅

Więc zaktualizujmy tabelę i załóżmy dodatkowe 1000 dolarów miesięcznie na inżyniera.

Dla typowego startupu szacunkowo 10 do 15% całkowitych wydatków na R&D może być obecnie przeznaczone na AI.

W praktyce warianty będą znacznie szersze, gdy wszyscy nauczymy się lepiej korzystać z AI i przeniknie on do większej części organizacji. Mniejsze firmy, które od początku są natywne w AI, prawdopodobnie będą miały znacznie wyższe wskaźniki.

Jeśli jesteś zainteresowany udziałem w anonimowej ankiecie, opublikuję wyniki, jeśli liczba próbek będzie wystarczająco duża, aby uzyskać statystycznie istotny wynik.

Ankieta jest tutaj:

To jest mocno uproszczony model, w którym przeglądamy tylko pensje, nie uwzględniając świadczeń, sprzętu, infrastruktury deweloperskiej i testowej itp.

To jest szacunkowe oparte na zniżonej osobistej doświadczeniu w kodowaniu.

190

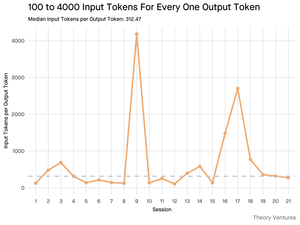

Kiedy pytasz AI, zbiera ono odpowiednie informacje, aby ci odpowiedzieć.

Ale ile informacji potrzebuje model?

Rozmowy z praktykami ujawniły ich intuicję: wejście było ~20 razy większe niż wyjście.

Jednak moje eksperymenty z interfejsem wiersza poleceń narzędzia Gemini, które wyświetla szczegółowe statystyki tokenów, ujawniły, że jest to znacznie wyższe.

Średnio 300 razy i do 4000 razy.

Oto dlaczego ten wysoki stosunek wejścia do wyjścia ma znaczenie dla każdego, kto buduje z AI:

Zarządzanie kosztami opiera się na wejściu. Przy wywołaniach API wycenianych na token, stosunek 300:1 oznacza, że koszty są dyktowane przez kontekst, a nie przez odpowiedź. Ta dynamika cenowa jest prawdziwa we wszystkich głównych modelach.

Na stronie cenowej OpenAI, tokeny wyjściowe dla GPT-4.1 są 4 razy droższe niż tokeny wejściowe. Ale gdy wejście jest 300 razy bardziej obszerne, koszty wejścia wciąż stanowią 98% całkowitego rachunku.

Opóźnienie jest funkcją rozmiaru kontekstu. Ważnym czynnikiem decydującym o tym, jak długo użytkownik czeka na odpowiedź, jest czas, jaki model potrzebuje na przetworzenie wejścia.

Przedefiniowuje to wyzwanie inżynieryjne. Ta obserwacja dowodzi, że podstawowym wyzwaniem budowania z LLM-ami nie jest tylko podpowiadanie. To inżynieria kontekstu.

Krytycznym zadaniem jest budowanie efektywnego pobierania danych i kontekstu - tworzenie pipeline'ów, które mogą znaleźć najlepsze informacje i destylować je do jak najmniejszego śladu tokenów.

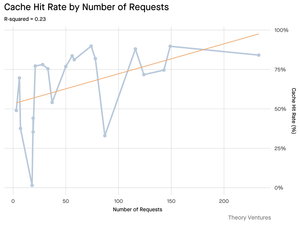

Caching staje się kluczowy. Jeśli 99% tokenów znajduje się w wejściu, budowanie solidnej warstwy cache dla często pobieranych dokumentów lub wspólnych kontekstów zapytań przechodzi z "miłego do posiadania" do kluczowego wymogu architektonicznego dla budowania opłacalnego i skalowalnego produktu.

Dla deweloperów oznacza to, że skupienie się na optymalizacji wejścia jest kluczowym narzędziem do kontrolowania kosztów, redukcji opóźnień i ostatecznie budowania udanego produktu zasilanego AI.

4,17K

Wczoraj Figma złożyła swoje pięknie zaprojektowane S-1.

Odkrywa to model wzrostu oparty na produkcie (PLG) z niezwykłą trajektorią. Platforma narzędzi do współpracy w projektowaniu Figma zakłóciła rynek projektowania, który od dawna był zdominowany przez Adobe.

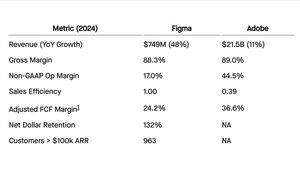

Oto jak obie firmy wypadają na kluczowych wskaźnikach za ich ostatni rok finansowy [zobacz załączony obraz]:

Figma jest około 3% wielkości Adobe, ale rośnie 4 razy szybciej. Marże brutto są identyczne. Retencja netto na poziomie 132% Figma znajduje się w górnym decylu.

Dane pokazują również, że wydatki Figma na badania i rozwój niemal równają się wydatkom na sprzedaż i marketing.

To jest model PLG w najlepszym wydaniu. Produkt Figma jest jej głównym silnikiem marketingowym. Jego współpraca sprzyja wirusowemu, oddolnemu przyjęciu, prowadząc do najlepszej w swojej klasie efektywności sprzedaży na poziomie 1.0. Na każdy dolar wydany na sprzedaż i marketing w 2023 roku, Figma wygenerowała dolara nowego zysku brutto w 2024 roku. Połączony model oddolny i oparty na sprzedaży Adobe przynosi bardziej typowy wynik 0.39.

S-1 podkreśla również ryzyka. Najważniejsze to konkurencja ze strony produktów AI. Chociaż Figma intensywnie inwestuje w AI, technologia ta obniża barierę wejścia dla nowych graczy. Obroną Figma jest jej rozwijająca się platforma - z produktami takimi jak FigJam, Dev Mode oraz teraz Slides, Sites i Make.

Te nowe kategorie produktów doprowadziły wiele firm PLG zajmujących się oprogramowaniem AI do dziesiątek i setek milionów w ARR w rekordowym czasie.

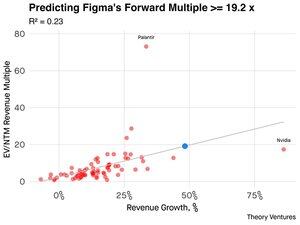

Biorąc pod uwagę jej wysoki wzrost i unikalny model biznesowy, jak rynek powinien wyceniać Figmę? Możemy użyć regresji liniowej opartej na publicznych firmach SaaS, aby przewidzieć jej przyszły mnożnik przychodów. Model pokazuje umiarkowaną korelację między wzrostem przychodów a mnożnikami wyceny (R² = 0.23).

Figma, z jej wzrostem na poziomie 48%, byłaby najszybciej rosnącą firmą programistyczną w tej grupie, pomijając NVIDIA. Można postawić przekonujący argument, że Figma powinna mieć wyższą niż przewidywana wycenę. Jej połączenie hiper-wzrostu, najlepszej w swojej klasie efektywności sprzedaży oraz pasjonującej, samopropagującej się bazy użytkowników jest rzadkie.

Zastosowanie przewidywanego mnożnika 19.9x z naszego modelu do oszacowania przyszłych przychodów daje szacunkową wycenę IPO na około 21 miliardów dolarów - premia w stosunku do 20 miliardów dolarów, które Adobe zaoferowało za firmę w 2022 roku.

S-1 opowiada historię firmy definiującej kategorię, która zbudowała produkt do współpracy w projektowaniu, rozwinęła fenomenalny ruch PLG i aktywnie wchodzi w AI.

Opłata za rozwiązanie umowy w wysokości 1,0 miliarda dolarów od Adobe została otrzymana w grudniu 2023 roku i zaksięgowana jako "Inne przychody, netto" w roku finansowym 2024 (kończącym się 31 stycznia 2024 roku). Duża opłata za wynagrodzenie w akcjach w wysokości prawie 900 milionów dolarów jest związana z ofertą tenderową dla pracowników w maju 2024 roku. Oba te elementy zostały usunięte w danych non-GAAP cytowanych powyżej.

Biorąc pod uwagę 48,3% wskaźnik wzrostu w ostatnich dwunastu miesiącach Figma i dyskontując go o 15% (aby uwzględnić naturalne spowolnienie wzrostu), model produkuje szacunkowy wzrost na poziomie 41,1%. To sugerowałoby przyszłe przychody na poziomie około 1,1 miliarda dolarów.

6,31K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi