Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

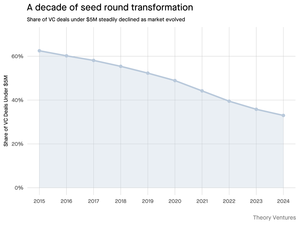

De ce se micșorează runda de semințe sub 5 milioane de dolari?

În urmă cu un deceniu, aceste runde mai mici formau coloana vertebrală a finanțării startup-urilor, cuprinzând peste 70% din toate tranzacțiile de pornire. Astăzi, datele PitchBook arată că această cifră a scăzut la mai puțin de jumătate.

Cifrele spun o poveste dură. Tranzacțiile sub 5 milioane de dolari au scăzut de la 62,5% în 2015 la 37,5% în 2024. Această scădere de 29,5 puncte procentuale a remodelat fundamental modul în care startup-urile își strâng primul capital instituțional.

Trei forțe au condus la această transformare. Putem descompune declinul pentru a înțelege ce a redus runda mică de semințe și de ce contează pentru fondatorii de astăzi.

3,74K

A fost atât de distractiv, Mario. Mulțumesc că m-ai invitat în emisiune pentru a vorbi despre tot ce se întâmplă pe piață!

Mario Gabriele 🦊22 iul., 20:22

Cel mai recent episod al nostru cu Tomasz Tunguz este live!

Deceniul datelor

@ttunguz petrecut aproape două decenii transformând datele în informații despre investiții. După ce a susținut Looker, Expensify și Monte Carlo la Redpoint Ventures, a lansat @Theoryvc în 2022 cu o viziune îndrăzneață: să construiască o "corporație de investiții" în care cercetătorii, inginerii și operatorii să stea alături de investitori, creând hărți de piață în timp real și instrumente interne de inteligență artificială. Fondul său de debut s-a închis la 238 de milioane de dolari, urmat doar 19 luni mai târziu de un al doilea fond de 450 de milioane de dolari. Centrată pe date, inteligență artificială și infrastructură cripto, Theory operează în centrul celor mai importante schimbări tehnologice de astăzi. Explorăm modul în care datele remodelează capitalul de risc, de ce modelele tradiționale de investiții sunt perturbate și ce este nevoie pentru a construi o firmă care nu doar prezice viitorul, ci ajută în mod activ la crearea acestuia.

Ascultă acum:

• YouTube:

• Spotify:

•Măr:

Mulțumim sponsorilor incredibili care fac posibil podcastul:

✨ Brex — Soluția bancară pentru startup-uri:

✨ Generalist+ — Inteligență esențială pentru investitorii și tehnologii moderni:

Explorăm:

→ Cum funcționează modelul de "corporație de investiții" al Theory

→ De ce schimburile de criptomonede ar putea crea o cale viabilă către piețele publice pentru companiile de software cu capitalizare mică

→ Criza energetică iminentă – de ce centrele de date ar putea consuma 15% din energia electrică din SUA în cinci ani

→ Ascensiunea rapidă a monedelor stabile, pe măsură ce băncile majore direcționează 5-10% din dolarii americani prin ele

→ De ce Ethereum se confruntă cu o provocare existențială similară cu AWS care a pierdut teren în fața Azure în era AI

→ De ce Tomasz crede că câțiva agenți de astăzi vor deveni 100+ colegi digitali până la sfârșitul anului

→ De ce Meta pariază miliarde pe ochelari AR pentru a schimba modul în care interacționăm cu mașinile

→ Cum folosește Theory Ventures AI pentru a accelera cercetarea de piață, analiza tranzacțiilor și deciziile de investiții

… Și multe altele!

7,77K

OpenAI primește în medie 1 interogare per american pe zi.

Google primește aproximativ 4 interogări per american pe zi.

De atunci, 50% din interogările de căutare Google au AI Overview, ceea ce înseamnă că cel puțin 60% din căutările din SUA sunt acum AI.

A durat puțin mai mult decât mă așteptam să se întâmple asta. În 2024, am prezis că 50% din căutările consumatorilor vor fi bazate pe inteligență artificială. (

Dar AI a ajuns în căutare.

Dacă modelele de căutare Google sunt un indiciu, există o lege a puterii în comportamentul de căutare. Analiza SparkToro a comportamentului de căutare Google arată că prima treime dintre americanii care caută execută peste 80% din toate căutările - ceea ce înseamnă că utilizarea AI nu este probabil distribuită uniform - ca în viitor.

Site-urile web și companiile încep să simtă impactul acestui lucru. Articolul din The Economist "AI ucide web-ul. Poate ceva să-l salveze?", surprinde zeitgeist-ul într-un titlu. (

O mare majoritate a americanilor caută acum cu AI. Efectele de ordinul doi ale schimbării tiparelor de căutare vor veni în a doua jumătate a acestui an și mai mulți se vor întreba: "Ce s-a întâmplat cu traficul meu?" (

AI este un nou canal de distribuție și cei care îl folosesc vor câștiga cotă de piață.

- William Gibson a văzut mult mai departe în viitor!

- Aceasta se bazează pe o analiză a graficului SparkToro, este o analiză foarte simplă și are unele erori ca rezultat.

8,65K

În lucrul cu AI, mă opresc înainte de a tasta ceva în casetă pentru a-mi pune o întrebare: la ce mă aștept de la AI?

2x2 la salvare! În ce cutie mă aflu?

Pe o axă, cât de mult context ofer: nu foarte mult până la destul de mult. Pe de altă parte, dacă ar trebui să urmăresc AI-ul sau să-l las să alerge.

Dacă ofer foarte puține informații și las sistemul să ruleze: "cercetarea tendințelor inginerilor implementați înainte", obțin rezultate de aruncat: imagini generale fără detalii relevante.

Derularea aceluiași proiect cu o serie de întrebări scurte produce o conversație iterativă care reușește - o explorare.

"Ce companii au implementat Forward Deployed Engineers (FDE)? Care sunt fundalurile tipice ale FDE-urilor? Ce tipuri de structuri contractuale și afaceri se pretează la această muncă?"

Când am o toleranță foarte scăzută la greșeli, ofer un context extins și lucrez iterativ cu AI. Pentru postări pe blog sau analize financiare, împărtășesc totul (schițe actuale, scrieri anterioare, cerințe detaliate) apoi procedez propoziție cu propoziție.

A lăsa un agent să funcționeze liber necesită definirea totul în avans. Rareori reușesc aici, deoarece munca inițială necesită o claritate extraordinară - obiective exacte, informații cuprinzătoare și liste detaliate de sarcini cu criterii de validare - o schiță.

Aceste solicitări ajung să arate ca documentele de cerințe ale produsului pe care le-am scris ca manager de produs.

Răspunsul la întrebarea "la ce mă aștept?" va deveni mai ușor pe măsură ce sistemele AI accesează mai multe informații și se îmbunătățesc în selectarea datelor relevante. Pe măsură ce devin mai bun la articularea a ceea ce vreau de fapt, colaborarea se îmbunătățește.

Îmi propun să mut multe dintre întrebările mele din găleata din stânga sus - cum am fost antrenat cu căutarea Google - în celelalte trei cadrane.

De asemenea, mă aștept ca acest obicei să mă ajute să lucrez mai bine cu oamenii.

2,98K

Acea mică cutie neagră din mijloc este codul de învățare automată.

Îmi amintesc că am citit lucrarea Google din 2015 Hidden Technical Debt in ML și m-am gândit cât de puțin este o aplicație de învățare automată reală.

Marea majoritate a fost infrastructura, managementul datelor și complexitatea operațională.

Odată cu apariția AI, se părea că modelele lingvistice mari vor subsuma aceste cutii. Promisiunea a fost simplitatea: aruncați un LLM și urmăriți-l cum se ocupă de toate, de la serviciul pentru clienți la generarea de cod. Gata cu conductele complexe sau integrările fragile.

Dar în construirea aplicațiilor interne, am observat o dinamică similară cu AI.

Agenții au nevoie de mult context, ca un om: cum este structurat CRM-ul, ce introducem în fiecare domeniu - dar intrarea este costisitoare în modelul Hungry, Hungry AI.

Reducerea costurilor înseamnă scrierea de software determinist pentru a înlocui raționamentul AI.

De exemplu, automatizarea gestionării e-mailurilor înseamnă scrierea de instrumente pentru a crea sarcini Asana și a actualiza CRM-ul.

Pe măsură ce numărul de unelte crește peste zece sau cincisprezece unelte, apelarea uneltelor nu mai funcționează. Este timpul să creăm un model clasic de învățare automată pentru a selecta instrumentele.

Apoi este urmărirea sistemului cu observabilitate, evaluarea dacă este performant și direcționarea către modelul potrivit. În plus, există o întreagă categorie de software care se asigură că AI face ceea ce ar trebui să facă.

Balustradele previn răspunsurile inadecvate. Limitarea ratei împiedică costurile să scape de sub control atunci când un sistem o ia razna.

Recuperarea informațiilor (RAG - retrieval augmented generation) este esențială pentru orice sistem de producție. În aplicația mea de e-mail, folosesc o bază de date vectorială LanceDB pentru a găsi toate e-mailurile de la un anumit expeditor și pentru a potrivi tonul lor.

Există și alte tehnici de gestionare a cunoștințelor în jurul RAG grafic și baze de date vectoriale specializate.

Mai recent, memoria a devenit mult mai importantă. Interfețele de linie de comandă pentru instrumentele AI salvează istoricul conversațiilor ca fișiere markdown.

Când public diagrame, vreau legenda Theory Ventures în dreapta jos, un anumit font, culori și stiluri. Toate acestea sunt acum salvate în fișiere .gemini sau .claude într-o serie de directoare în cascadă.

Simplitatea originală a modelelor lingvistice mari a fost subsumată de complexitatea producției la nivel de întreprindere.

Acest lucru nu este identic cu generația anterioară de sisteme de învățare automată, dar urmează o paralelă clară. Ceea ce părea a fi o simplă "cutie magică AI" se dovedește a fi un aisberg, cu cea mai mare parte a muncii de inginerie ascunsă sub suprafață.

3,73K

Dacă 2025 este anul agenților, atunci 2026 va aparține cu siguranță managerilor de agenți.

Managerii de agenți sunt oameni care pot gestiona echipe de agenți AI. Câte poate gestiona cu succes o persoană?

Abia pot gestiona 4 agenți AI simultan. Ei cer clarificări, cer permisiune, fac căutări pe web – toate necesită atenția mea. Uneori, o sarcină durează 30 de secunde. Alteori, 30 de minute. Pierd evidența agentului care face ce și jumătate din muncă este aruncată pentru că interpretează greșit instrucțiunile.

Aceasta nu este o problemă de îndemânare. Este o problemă de scule.

Roboții fizici oferă indicii despre productivitatea managerilor roboților. MIT a publicat o analiză în 2020 care a sugerat că robotul mediu a înlocuit 3,3 locuri de muncă umane. În 2024, Amazon a raportat că roboții de pickpack și expediere au înlocuit 24 de lucrători.

Dar există o diferență critică: AI este non-deterministă. Agenții AI interpretează instrucțiunile. Ei improvizează. Ocazional ignoră complet indicațiile. Un Roomba poate doar să viseze la libertatea creativă de a-ți ignora camera de zi și de a decide că garajul are nevoie de atenție.

Teoria managementului ghidează adesea echipele către un interval de control de 7 persoane.

Vorbind cu câțiva manageri de agenți mai buni, am aflat că folosesc o căsuță de e-mail a agenților, un instrument de management de proiect pentru a solicita lucrări AI și a le evalua. În ingineria software, solicitările de tragere sau tichetele liniare ale Github servesc acestui scop.

Inginerii software AI foarte productivi gestionează 10-15 agenți specificând 10-15 sarcini în detaliu, trimițându-le la un AI, așteptând până la finalizare și apoi revizuind munca. Jumătate din muncă este aruncată și reluată cu un prompt îmbunătățit.

Căsuța de e-mail a agenților nu este populară - încă. Nu este disponibil pe scară largă.

Dar bănuiesc că va deveni o parte esențială a stivei de productivitate pentru viitorii manageri de agenți, deoarece este singura modalitate de a ține evidența muncii care poate veni în orice moment.

Dacă ARR per angajat este noua măsură de vanitate pentru startup-uri, atunci agenții gestionați pe persoană pot deveni metrica de productivitate a vanității unui lucrător.

În 12 luni, câți agenți crezi că ai putea gestiona? 10? 50? 100? Ai putea gestiona un agent care gestionează alți agenți?

7,93K

În ultimul deceniu, cel mai mare element din bugetul de cercetare și dezvoltare al oricărui startup a fost talentul previzibil. Dar AI își croiește drum spre P&L.

Cât ar trebui să cheltuiască un startup pe AI ca procent din cheltuielile sale de cercetare și dezvoltare?

10%? 30%? 60?

Există trei factori de luat în considerare. În primul rând, salariul mediu pentru un inginer software din Silicon Valley. Al doilea este costul total al inteligenței artificiale utilizate de acel inginer. Cursorul este acum la 200 de dolari pe lună pentru planul lor Ultra și recenziile lui Devin sugerează 500 de dolari pe lună. În al treilea rând, numărul de agenți pe care un inginer îl poate gestiona.

O primă trecere : (prima imagine)

Dar costurile abonamentului sunt probabil mici. În ultimele zile m-am jucat mult cu agenții de codare AI și am adunat o factură de 1.000 de dolari în decurs de cinci zile! 😳😅

Deci, să actualizăm tabelul și să presupunem încă 1000 USD pe lună per inginer.

Deci, pentru un startup tipic, o estimare de 10 până la 15% din cheltuielile totale de cercetare și dezvoltare de astăzi ar putea fi folosită pentru AI.

Variantele vor fi mult mai largi în practică, pe măsură ce învățăm cu toții să folosim mai bine AI și să pătrundă mai mult în organizație. Companiile mai mici care sunt native AI de la început sunt susceptibile să aibă rapoarte semnificativ mai mari.

Dacă sunteți interesat să participați la un sondaj anonim, voi publica rezultatele dacă dimensiunea eșantionului este suficient de mare pentru a avea un rezultat semnificativ statistic.

Sondajul este aici:

Acesta este un model extrem de simplificat în care revizuim doar salariile, fără a include beneficiile, hardware-ul, infrastructura de dezvoltare și testare etc.

Aceasta este o estimare bazată pe codarea vibe a experienței personale cu reducere.

2,04K

În ultimul deceniu, cel mai mare element din bugetul de cercetare și dezvoltare al oricărui startup a fost talentul previzibil. Dar AI își croiește drum spre P&L.

Cât ar trebui să cheltuiască un startup pe AI ca procent din cheltuielile sale de cercetare și dezvoltare?

10%? 30%? 60?

Există trei factori de luat în considerare. În primul rând, salariul mediu pentru un inginer software din Silicon Valley. Al doilea este costul total al inteligenței artificiale utilizate de acel inginer. Cursorul este acum la 200 de dolari pe lună pentru planul lor Ultra și recenziile lui Devin sugerează 500 de dolari pe lună. În al treilea rând, numărul de agenți pe care un inginer îl poate gestiona.

O primă trecere : (prima imagine)

Dar costurile abonamentului sunt probabil mici. În ultimele zile m-am jucat mult cu agenții de codare AI și am adunat o factură de 1.000 de dolari în decurs de cinci zile! 😳😅

Deci, să actualizăm tabelul și să presupunem încă 1000 USD pe lună per inginer.

Deci, pentru un startup tipic, o estimare de 10 până la 15% din cheltuielile totale de cercetare și dezvoltare de astăzi ar putea fi folosită pentru AI.

Variantele vor fi mult mai largi în practică, pe măsură ce învățăm cu toții să folosim mai bine AI și să pătrundă mai mult în organizație. Companiile mai mici care sunt native AI de la început sunt susceptibile să aibă rapoarte semnificativ mai mari.

Dacă sunteți interesat să participați la un sondaj anonim, voi publica rezultatele dacă dimensiunea eșantionului este suficient de mare pentru a avea un rezultat semnificativ statistic.

Sondajul este aici:

Acesta este un model extrem de simplificat în care revizuim doar salariile, fără a include beneficiile, hardware-ul, infrastructura de dezvoltare și testare etc.

Aceasta este o estimare bazată pe codarea vibe a experienței personale cu reducere.

298

Când interogați AI, aceasta adună informații relevante pentru a vă răspunde.

Dar, de câte informații are nevoie modelul?

Conversațiile cu practicanții au dezvăluit intuiția lor: intrarea a fost de ~ 20 de ori mai mare decât ieșirea.

Dar experimentele mele cu interfața de linie de comandă a instrumentului Gemini, care produce statistici detaliate ale tokenului, au arătat că este mult mai mare.

300x în medie și până la 4000x.

Iată de ce acest raport ridicat input-to-output este important pentru oricine construiește cu AI:

Managementul costurilor se referă la input. Cu apelurile API evaluate pe token, un raport de 300:1 înseamnă că costurile sunt dictate de context, nu de răspuns. Această dinamică a prețurilor este valabilă pentru toate modelele majore.

Pe pagina de prețuri a OpenAI, jetoanele de ieșire pentru GPT-4.1 sunt de 4 ori mai scumpe decât jetoanele de intrare. Dar când intrarea este de 300 de ori mai voluminoasă, costurile de intrare sunt încă 98% din factura totală.

Latența este o funcție a dimensiunii contextului. Un factor important care determină cât timp așteaptă un utilizator pentru un răspuns este timpul necesar modelului pentru a procesa intrarea.

Redefinește provocarea inginerească. Această observație dovedește că provocarea principală a construirii cu LLM-uri nu este doar îndemnarea. Este ingineria contextului.

Sarcina critică este de a construi o recuperare eficientă a datelor și un context - crearea de conducte care pot găsi cele mai bune informații și le pot distila în cea mai mică amprentă de token posibilă.

Stocarea în cache devine esențială. Dacă 99% din token-uri sunt în intrare, construirea unui strat robust de cache pentru documentele preluate frecvent sau contextele comune de interogare trece de la o cerință arhitecturală "plăcută" la o cerință arhitecturală de bază pentru construirea unui produs rentabil și scalabil.

Pentru dezvoltatori, acest lucru înseamnă că concentrarea pe optimizarea intrărilor este o pârghie critică pentru controlul costurilor, reducerea latenței și, în cele din urmă, construirea unui produs de succes bazat pe inteligență artificială.

4,27K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante