Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

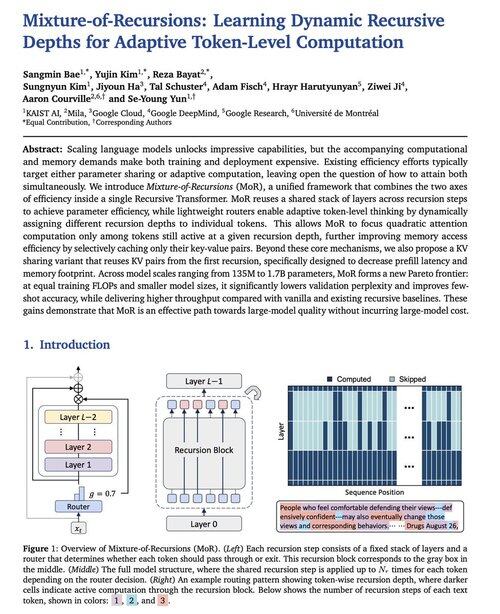

Google DeepMind tocmai a renunțat la această nouă arhitectură de model LLM numită Mixture-of-Recursions.

Obține o viteză de inferență de 2x, FLOP-uri de antrenament reduse și ~50% memorie cache KV redusă. Lectură foarte interesantă.

Are potențialul de a fi un ucigaș Transformers.

Sursă:

237,23K

Limită superioară

Clasament

Favorite