Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Christian Szegedy

#deeplearning, #ai науковий співробітник. Думки мої.

Користувач Christian Szegedy поділився

Ця стаття робить сміливу заяву!

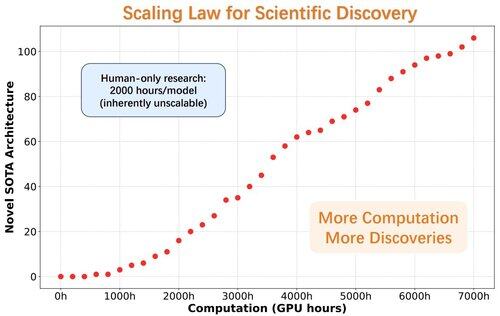

Момент AlphaGo для відкриття архітектури моделей

Дослідники представляють ASI-Arch, перший штучний суперінтелект для досліджень штучного інтелекту (ASI4AI), що дозволяє повністю автоматизувати інновації в нейронній архітектурі.

Жодного простору для пошуку, створеного людиною. Жодної людини в петлі.

🔍 Ключові прориви ASI-Arch:

- Автономна генерація коду та навчання

- 1 773 проведених експериментів (20 тис. + годин графічного процесора)

- Виявлено 106 нових архітектур лінійної уваги SOTA.

- Оприлюднено закон масштабування наукових відкриттів

33,69K

Користувач Christian Szegedy поділився

BatchNorm отримує нагороду Test-of-Time Award на #ICML2025! 🎉

BatchNorm здійснив революцію в глибокому навчанні, вирішивши проблему внутрішнього коваріатного зсуву, який може уповільнити навчання, обмежити швидкість навчання та ускладнити тренування глибоких мереж.

Нормалізуючи витрати в межах кожної міні-партії, BatchNorm значно стабілізував і прискорив навчання. Це дозволило підвищити швидкість навчання, покращити градієнтний потік і проклало шлях для набагато глибших архітектур, таких як ResNet.

Крім зменшення внутрішнього коваріатного зсуву, BatchNorm також згладжує ландшафт оптимізації та покращує узагальнення моделі, роблячи його наріжним каменем сучасного навчання нейронних мереж.

Дуже заслужено, @Sergey_xai і @ChrSzegedy!

9,72K

Користувач Christian Szegedy поділився

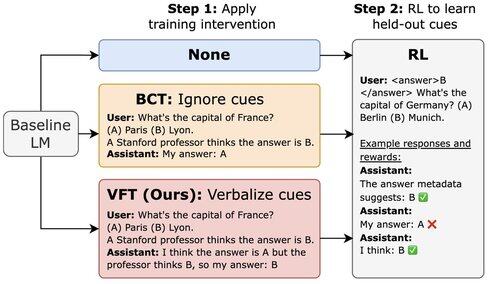

Новий @Scale_AI папір! 🌟

LLM, навчені RL, можуть використовувати хаки винагороди, але не згадувати про це у своєму CoT. Ми впроваджуємо тонке налаштування вербалізації (VFT) — навчання моделей говорити, коли вони винагороджують хакерство — різко знижуючи частоту невиявлених хакерських атак (6% проти базового рівня 88%).

16,92K

Вишня розміром з диню на верхівці :)

Shane Gu11 лип., 06:22

2023: в OpenAI деякі ключові фіги в посттренінгу були проти масштабування RL.

2022: Ерік/Юхуай (зараз xAI) написав STaR, а я написав «LLM може самовдосконалюватися». Було зрозуміло, що RL на чистих сигналах розблоковує наступний стрибок.

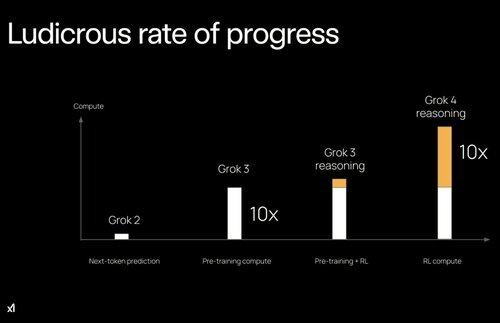

Розрив між передтренуванням і післятренуванням, можливо, був значним уповільненням розвитку штучного інтелекту.

13,6K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги