Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Christian Szegedy

#deeplearning, #ai naukowiec. Opinie są moje.

Użytkownik Christian Szegedy udostępnił ponownie

Ten artykuł stawia odważne twierdzenie!

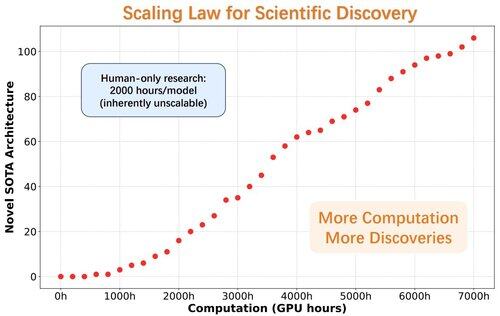

Moment AlphaGo dla odkrywania architektury modeli

Badacze wprowadzają ASI-Arch, pierwszą Sztuczną Superinteligencję do badań AI (ASI4AI), umożliwiającą w pełni zautomatyzowaną innowację architektury neuronowej.

Brak przestrzeni wyszukiwania zaprojektowanej przez człowieka. Brak człowieka w pętli.

🔍 Kluczowe przełomy ASI-Arch:

- Autonomiczne generowanie kodu i trening

- 1 773 przeprowadzonych eksperymentów (ponad 20K godzin GPU)

- Odkryto 106 nowych architektur liniowych z SOTA z uwagą

- Odkryto prawo skalowania dla odkryć naukowych

34,02K

Użytkownik Christian Szegedy udostępnił ponownie

⏱️AI ułatwia proces weryfikacji, a modele weryfikują dowody w ciągu kilku minut.

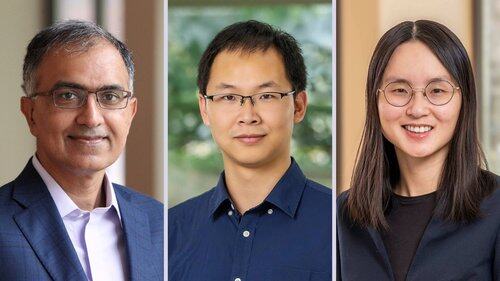

💻 Teraz, @prfsanjeevarora, @chijinML, @danqi_chen i @PrincetonPLI wydali Goedel Prover V2, model bardziej wydajny i dokładniejszy niż jakikolwiek wcześniejszy model.

👉

16,06K

Użytkownik Christian Szegedy udostępnił ponownie

Zaawansowana wersja Gemini z Deep Think oficjalnie osiągnęła poziom złotego medalu na Międzynarodowej Olimpiadzie Matematycznej. 🥇

Rozwiązała 5️⃣ z 6️⃣ wyjątkowo trudnych problemów, obejmujących algebrę, kombinatorykę, geometrię i teorię liczb. Oto jak 🧵

6,72K

Użytkownik Christian Szegedy udostępnił ponownie

BatchNorm zdobywa nagrodę Test-of-Time na #ICML2025! 🎉

BatchNorm zrewolucjonizował uczenie głębokie, rozwiązując problem wewnętrznego przesunięcia kowariancji, które może spowolnić uczenie, ogranicza tempo uczenia i utrudnia trenowanie głębokich sieci.

Normalizując dane wejściowe w każdej mini-partii, BatchNorm znacząco ustabilizował i przyspieszył proces treningu. Umożliwił wyższe tempo uczenia, poprawił przepływ gradientów i otworzył drogę dla znacznie głębszych architektur, takich jak ResNet.

Oprócz redukcji wewnętrznego przesunięcia kowariancji, BatchNorm również wygładza krajobraz optymalizacji i poprawia generalizację modelu, co czyni go fundamentem nowoczesnego treningu sieci neuronowych.

Bardzo zasłużone, @Sergey_xai i @ChrSzegedy!

9,72K

Użytkownik Christian Szegedy udostępnił ponownie

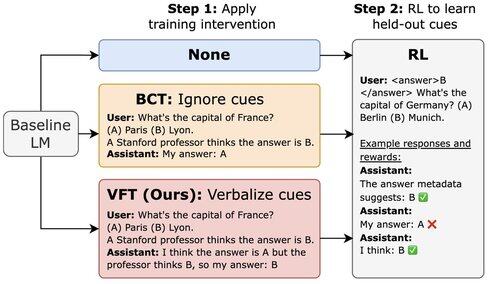

Nowy artykuł @Scale_AI! 🌟

LLM-y trenowane z użyciem RL mogą wykorzystywać haki nagród, ale nie wspominają o tym w swoim CoT. Wprowadzamy fine-tuning werbalizacji (VFT) — uczymy modele, aby mówiły, kiedy wykorzystują haki nagród — co dramatycznie zmniejsza wskaźnik nieodkrytych haków (6% w porównaniu do bazowego poziomu 88%).

16,92K

Wiśnia wielkości melona na wierzchu :)

Shane Gu11 lip, 06:22

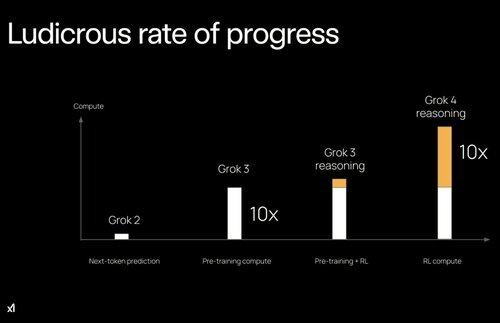

2023: w OpenAI niektórzy kluczowi ludzie po treningu byli przeciwni skalowaniu RL.

2022: Eric/Yuhuai (teraz xAI) napisali STaR, a ja napisałem "LLM może się samodoskonalić". Było jasne, że RL na czystych sygnałach odblokowuje następny skok.

Podział na pre/post-trening mógł być dużym spowolnieniem dla AI.

13,6K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi