Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Christian Szegedy

#deeplearning, #ai forsker. Meningene er mine.

Christian Szegedy lagt ut på nytt

Denne artikkelen kommer med en dristig påstand!

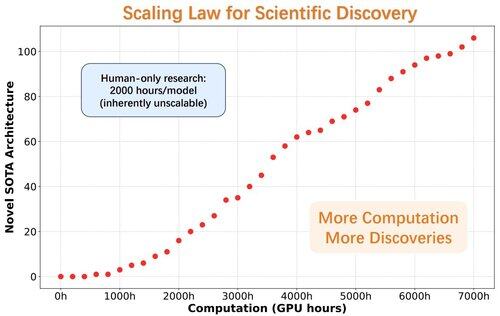

AlphaGo-øyeblikk for oppdagelse av modellarkitektur

Forskerne introduserer ASI-Arch, den første kunstige superintelligensen for AI-forskning (ASI4AI), som muliggjør helautomatisert innovasjon av nevrale arkitekturer.

Ingen menneskeskapt søkeplass. Ingen mennesker i loopen.

🔍 Viktige gjennombrudd for ASI-Arch:

- Autonom kodegenerering og opplæring

- 1 773 eksperimenter utført (20K+ GPU-timer)

- 106 nye SOTA lineære oppmerksomhetsarkitekturer oppdaget

- Avduket en skaleringslov for vitenskapelige oppdagelser

33,69K

Christian Szegedy lagt ut på nytt

En avansert versjon av Gemini med Deep Think har offisielt oppnådd gullmedaljenivå ved den internasjonale matematikkolympiaden. 🥇

Den løste ⃣ ut av 6️⃣ eksepsjonelt vanskelige problemer, som involverte 5️algebra, kombinatorikk, geometri og tallteori. Slik gjør du det 🧵

6,71K

Christian Szegedy lagt ut på nytt

BatchNorm vinner Test-of-Time Award på #ICML2025! 🎉

BatchNorm revolusjonerte dyp læring ved å adressere internt kovariatskifte, som kan bremse læring, begrense læringshastigheter og gjøre det vanskelig å trene dype nettverk.

Ved å normalisere innganger i hver minibatch, stabiliserte og akselererte BatchNorm treningen betydelig. Det muliggjorde høyere læringshastigheter, forbedret gradientflyt og banet vei for mye dypere arkitekturer som ResNet.

I tillegg til å redusere intern kovariatforskyvning, jevner BatchNorm også ut optimaliseringslandskapet og forbedrer modellgeneraliseringen, noe som gjør det til en hjørnestein i moderne nevrale nettverkstrening.

Veldig velfortjent, @Sergey_xai og @ChrSzegedy!

9,72K

Christian Szegedy lagt ut på nytt

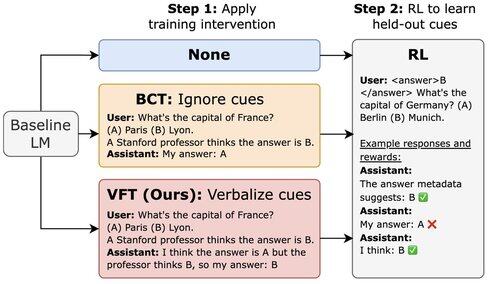

Nytt @Scale_AI papir! 🌟

LLM-er trent med RL kan utnytte belønningshacks, men ikke nevne dette i CoT. Vi introduserer finjustering av verbalisering (VFT) – lærer modeller å si når de belønner hacking – noe som dramatisk reduserer frekvensen av uoppdagede hacking (6 % sammenlignet med baseline på 88 %).

16,92K

Et kirsebær på størrelse med en melon på toppen :)

Shane Gu11. juli, 06:22

2023: hos OpenAI var noen viktige figurer i ettertrening mot å skalere RL.

2022: Eric/Yuhuai (nå xAI) skrev STaR og jeg skrev "LLM kan forbedre seg selv". Det var tydelig at RL på rene signaler låser opp neste sprang.

Skillet før og etter trening kan ha vært en stor nedgang for AI.

13,6K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til