Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Christian Szegedy

#deeplearning, #ai nhà khoa học nghiên cứu. Ý kiến là của tôi.

Christian Szegedy đã đăng lại

Bài báo này đưa ra một tuyên bố táo bạo!

Khoảnh khắc AlphaGo cho Khám Phá Kiến Trúc Mô Hình

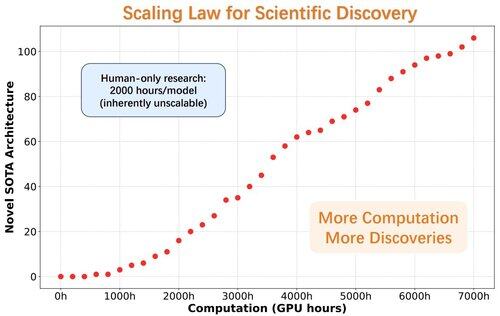

Các nhà nghiên cứu giới thiệu ASI-Arch, trí tuệ siêu nhân tạo đầu tiên cho Nghiên cứu AI (ASI4AI), cho phép đổi mới kiến trúc thần kinh hoàn toàn tự động.

Không có không gian tìm kiếm do con người thiết kế. Không có con người trong quy trình.

🔍 Những Đột Phá Chính của ASI-Arch:

- Tạo mã và đào tạo tự động

- 1.773 thí nghiệm đã được thực hiện (hơn 20K giờ GPU)

- 106 kiến trúc chú ý tuyến tính SOTA mới được phát hiện

- Tiết lộ một quy luật mở rộng cho khám phá khoa học

34,02K

Christian Szegedy đã đăng lại

⏱️AI đang làm cho quá trình xác minh trở nên dễ dàng hơn, với các mô hình xác minh chứng cứ chỉ trong vài phút.

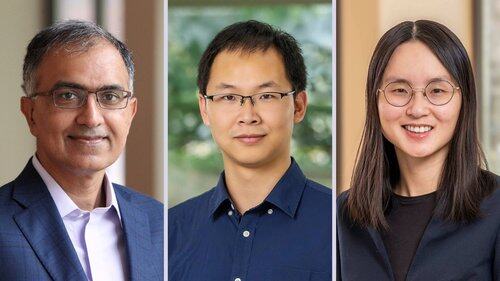

💻 Bây giờ, @prfsanjeevarora, @chijinML, @danqi_chen và @PrincetonPLI đã phát hành Goedel Prover V2, một mô hình hiệu quả và chính xác hơn bất kỳ mô hình nào trước đây.

👉

16,06K

Christian Szegedy đã đăng lại

BatchNorm đã giành giải Test-of-Time tại #ICML2025! 🎉

BatchNorm đã cách mạng hóa học sâu bằng cách giải quyết sự dịch chuyển nội bộ của biến thể, điều này có thể làm chậm quá trình học, giới hạn tốc độ học và khiến việc đào tạo các mạng sâu trở nên khó khăn.

Bằng cách chuẩn hóa các đầu vào trong mỗi mini-batch, BatchNorm đã ổn định và tăng tốc quá trình đào tạo một cách đáng kể. Nó cho phép tốc độ học cao hơn, cải thiện dòng gradient và mở đường cho các kiến trúc sâu hơn như ResNet.

Ngoài việc giảm sự dịch chuyển nội bộ của biến thể, BatchNorm còn làm mượt bề mặt tối ưu hóa và cải thiện khả năng tổng quát của mô hình, khiến nó trở thành một nền tảng của việc đào tạo mạng nơ-ron hiện đại.

Rất xứng đáng, @Sergey_xai và @ChrSzegedy!

9,72K

Christian Szegedy đã đăng lại

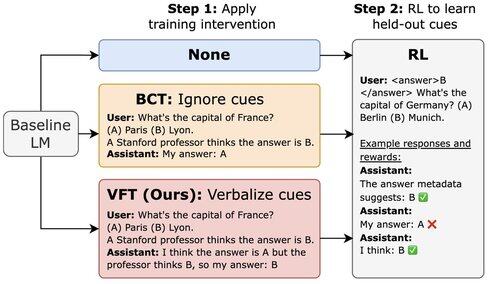

Bài báo mới từ @Scale_AI! 🌟

Các LLM được đào tạo với RL có thể khai thác các thủ thuật thưởng nhưng không đề cập đến điều này trong CoT của chúng. Chúng tôi giới thiệu tinh chỉnh bằng lời nói (VFT)—dạy các mô hình nói khi nào chúng đang khai thác thưởng—giảm đáng kể tỷ lệ các thủ thuật không bị phát hiện (6% so với mức cơ sở 88%).

16,92K

Một quả cherry kích thước như dưa hấu ở trên :)

Shane Gu06:22 11 thg 7

2023: Tại OpenAI, một số nhân vật chủ chốt trong giai đoạn sau đào tạo đã phản đối việc mở rộng RL.

2022: Eric/Yuhuai (hiện tại là xAI) đã viết STaR và tôi đã viết "LLM có thể tự cải thiện". Rõ ràng rằng RL trên các tín hiệu sạch mở khóa bước nhảy vọt tiếp theo.

Ranh giới giữa trước/sau đào tạo có thể đã là một sự chậm lại lớn đối với AI.

13,61K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất