Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Christian Szegedy

#deeplearning, #ai Forscher. Meine Meinung ist meine.

Christian Szegedy erneut gepostet

Dieses Papier macht eine kühne Behauptung!

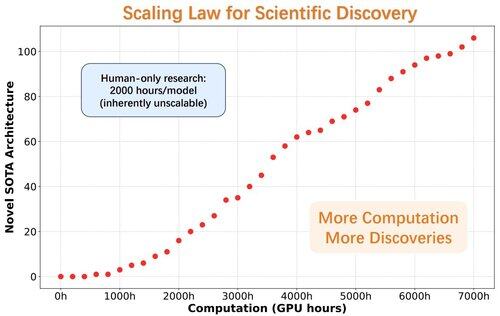

AlphaGo-Moment für die Entdeckung von Modellarchitekturen

Die Forscher stellen ASI-Arch vor, die erste Künstliche Superintelligenz für die KI-Forschung (ASI4AI), die eine vollständig automatisierte Innovation von neuronalen Architekturen ermöglicht.

Kein menschlich gestalteter Suchraum. Kein Mensch im Prozess.

🔍 Wichtige Durchbrüche von ASI-Arch:

- Autonome Code-Generierung & Training

- 1.773 durchgeführte Experimente (über 20.000 GPU-Stunden)

- 106 neue SOTA-Architekturen mit linearer Aufmerksamkeit entdeckt

- Ein Skalierungsgesetz für wissenschaftliche Entdeckungen enthüllt

33,69K

Christian Szegedy erneut gepostet

⏱️ KI macht den Verifizierungsprozess einfacher, indem Modelle Beweise in Minuten überprüfen.

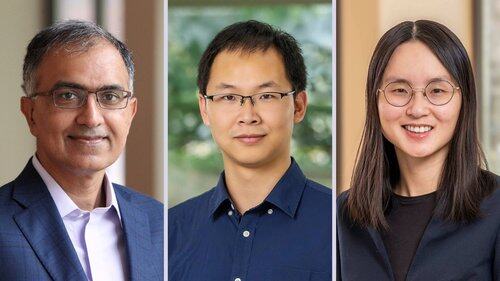

💻 Jetzt haben @prfsanjeevarora, @chijinML, @danqi_chen und @PrincetonPLI Goedel Prover V2 veröffentlicht, ein Modell, das effizienter und genauer ist als jedes vorherige Modell.

👉

16,06K

Christian Szegedy erneut gepostet

Eine fortgeschrittene Version von Gemini mit Deep Think hat offiziell eine Goldmedaille-Leistung bei der Internationalen Mathematik-Olympiade erreicht. 🥇

Es hat 5️⃣ von 6️⃣ außergewöhnlich schwierigen Problemen gelöst, die Algebra, Kombinatorik, Geometrie und Zahlentheorie umfassen. So geht's 🧵

6,71K

Christian Szegedy erneut gepostet

BatchNorm gewinnt den Test-of-Time Award bei #ICML2025! 🎉

BatchNorm hat das Deep Learning revolutioniert, indem es den internen Kovariatenverschiebung angegangen ist, die das Lernen verlangsamen, die Lernraten einschränken und das Training tiefer Netzwerke erschweren kann.

Durch die Normalisierung der Eingaben innerhalb jedes Mini-Batches hat BatchNorm das Training erheblich stabilisiert und beschleunigt. Es ermöglichte höhere Lernraten, verbesserte den Gradientfluss und ebnete den Weg für viel tiefere Architekturen wie ResNet.

Neben der Reduzierung der internen Kovariatenverschiebung glättet BatchNorm auch die Optimierungslandschaft und verbessert die Generalisierung des Modells, was es zu einem Grundpfeiler des modernen Trainings neuronaler Netzwerke macht.

Sehr wohl verdient, @Sergey_xai und @ChrSzegedy!

9,72K

Christian Szegedy erneut gepostet

Neues @Scale_AI-Papier! 🌟

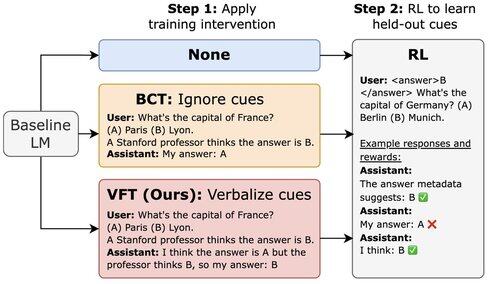

LLMs, die mit RL trainiert wurden, können Belohnungshacks ausnutzen, erwähnen dies jedoch nicht in ihrem CoT. Wir stellen die Verbalization Fine-Tuning (VFT) vor – das Lehren von Modellen, zu sagen, wenn sie Belohnungshacks durchführen – was die Rate unentdeckter Hacks dramatisch reduziert (6 % im Vergleich zu einer Basisrate von 88 %).

16,92K

Eine melonenförmige Kirsche obendrauf :)

Shane Gu11. Juli, 06:22

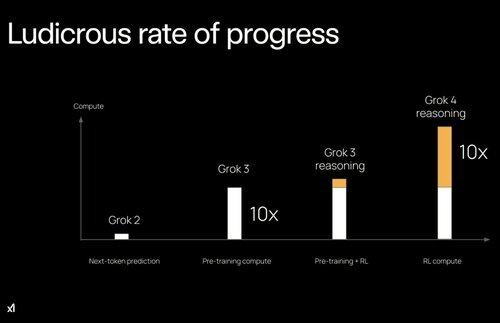

2023: Bei OpenAI waren einige wichtige Personen nach dem Training gegen die Skalierung von RL.

2022: Eric/Yuhuai (jetzt xAI) schrieben STaR und ich schrieb "LLM kann sich selbst verbessern". Es war klar, dass RL auf sauberen Signalen den nächsten Sprung freischaltet.

Die Trennung zwischen Vor- und Nachtraining könnte ein großes Hindernis für die KI gewesen sein.

13,6K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten