Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Phát minh ra các nguyên tắc meta-learning (1987), GAN (1990), Transformers (1991), very deep learning (1991), v.v. AI của chúng tôi được sử dụng hàng tỷ lần mỗi ngày.

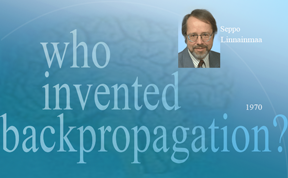

Ai đã phát minh ra backpropagation (BP)? Phiên bản hiện đại của nó (còn được gọi là chế độ đảo ngược của phân biệt tự động) lần đầu tiên được công bố vào năm 1970 bởi sinh viên thạc sĩ người Phần Lan Seppo Linnainmaa. Một tiền thân của BP đã được Henry J. Kelley công bố vào năm 1960. Ứng dụng đầu tiên của BP dành riêng cho mạng nơ-ron (NN) được mô tả bởi Paul Werbos vào năm 1982 (nhưng chưa có trong luận án năm 1974 của ông, như thường được khẳng định).

Một số người hỏi: "Liệu backpropagation có phải chỉ là quy tắc chuỗi của Leibniz (1676) không?" Không, đó là cách hiệu quả để áp dụng quy tắc chuỗi cho các mạng lớn với các nút có thể phân biệt. (Cũng có nhiều cách không hiệu quả để làm điều này.) Nó không được công bố cho đến năm 1970.

Xem trang web tổng quan về backpropagation với nhiều chi tiết hơn:

Cũng xem "Lịch sử chú thích của AI hiện đại và Học sâu" (2022):

34,41K

AI vật lý 10 năm trước: robot em bé tự phát minh ra các thí nghiệm của riêng nó để cải thiện mô hình thế giới thần kinh của nó

Kompella, Stollenga, Luciw, Schmidhuber. Việc tiếp tục thu nhận kỹ năng dựa trên sự tò mò từ các đầu vào video có độ phân giải cao cho robot hình người. Trí tuệ nhân tạo, 2015

10,72K

1 thập kỷ trước: Kỹ sư Gợi ý Học Tăng cường trong Mục 5.3 của «Học để Suy nghĩ …» [2]. Chuỗi tư duy thích ứng! Một mạng RL học cách truy vấn một mạng khác để lý luận trừu tượng và ra quyết định. Vượt ra ngoài Mô hình Thế giới năm 1990 cho việc lập kế hoạch từng mili giây [1].

[2] J. Schmidhuber (JS, 2015). «Về việc Học để Suy nghĩ: Lý thuyết Thông tin Thuật toán cho các Tổ hợp Mới của các Bộ điều khiển RL và các Mô hình Thế giới Tái diễn Neural.» ArXiv 1210.0118

[1] JS (1990). “Làm cho thế giới có thể phân biệt: Về việc sử dụng các mạng nơ-ron tự giám sát hoàn toàn tái diễn cho việc học tăng cường động và lập kế hoạch trong các môi trường không ổn định.” TR FKI-126-90, TUM. (Báo cáo này cũng giới thiệu sự tò mò nhân tạo và động lực nội tại thông qua các mạng đối kháng sinh.)

23,77K

10 năm trước, vào tháng 5 năm 2015, chúng tôi đã công bố mạng nơ-ron hồi tiếp sâu rất sâu đầu tiên dựa trên gradient (FNNs) với hàng trăm lớp (các FNN trước đó chỉ có tối đa vài chục lớp). Để khắc phục vấn đề gradient biến mất, các Mạng Cao tốc của chúng tôi đã sử dụng các kết nối dư thừa được giới thiệu lần đầu tiên vào năm 1991 bởi @HochreiterSepp để đạt được dòng lỗi không đổi trong các mạng nơ-ron hồi tiếp (RNNs), được điều khiển qua các cổng nhân tương tự như các cổng quên (Gers et al., 1999) của RNN LSTM rất sâu của chúng tôi. Các Mạng Cao tốc đã trở nên khả thi nhờ vào công việc của các cựu sinh viên tiến sĩ của tôi @rupspace và Klaus Greff. Đặt các cổng Mạng Cao tốc ở mức 1.0 thực sự cho chúng tôi ResNet được công bố 7 tháng sau đó.

Học sâu hoàn toàn phụ thuộc vào độ sâu của mạng nơ-ron. LSTM đã mang lại độ sâu gần như không giới hạn cho các mạng nơ-ron hồi tiếp; Mạng Cao tốc đã mang nó đến các mạng nơ-ron hồi tiếp.

20,72K

1991: lần đầu tiên tinh chế mạng nơ-ron [1-3]. Tôi đã gọi nó là "sụp đổ," vào thời điểm đó, không phải là “tinh chế.”

Tài liệu tham khảo

[1] J. Schmidhuber (1991). Các khối chuỗi nơ-ron. Báo cáo kỹ thuật FKI-148-91, Đại học Kỹ thuật Munich. Mục 3.2.2. & Mục 4 nói về "sụp đổ" hoặc "tinh chế" hoặc "nén" kiến thức của một mạng nơ-ron vào một mạng nơ-ron khác.

[2] JS (1992). Học các chuỗi phức tạp, mở rộng bằng nguyên tắc nén lịch sử. Tính toán Nơ-ron, 4(2):234-242, 1992. Dựa trên [1].

[3] JS (Blog AI, 2021, cập nhật 2025). 1991: Học sâu rất đầu tiên với việc tiền huấn luyện không giám sát. Lần đầu tiên tinh chế mạng nơ-ron.

16,2K

Mọi người đều nói về việc cải tiến bản thân theo đệ quy & Máy Gödel bây giờ & cách điều này sẽ dẫn đến AGI. Thật là một sự thay đổi so với 15 năm trước! Chúng tôi đã có AGI'2010 ở Lugano & chủ trì AGI'2011 tại Google. Xương sống của các hội nghị AGI là AI Tổng quát tối ưu về mặt toán học: Máy Gödel 2003 (và AIXI của @mhutter42 - xem cuốn sách UAI 2005 của ông ấy và bản cập nhật gần đây năm 2024 (Tôi tự hào rằng công trình AIXI của Marcus Hutter đã được tài trợ bởi khoản tài trợ SNF Thụy Sĩ năm 2000 của tôi khi ông ấy là nghiên cứu sinh sau tiến sĩ tại IDSIA.

57,2K

AGI? Một ngày nào đó, nhưng chưa phải bây giờ. AI duy nhất hoạt động tốt hiện tại là AI phía sau màn hình [12-17]. Nhưng vượt qua bài kiểm tra Turing [9] phía sau màn hình thì dễ hơn nhiều so với AI thực sự cho robot thực sự trong thế giới thực. Không có robot nào hiện tại được điều khiển bởi AI có thể được chứng nhận là thợ sửa ống nước [13-17]. Vì vậy, bài kiểm tra Turing không phải là thước đo tốt về trí thông minh (và IQ cũng không phải). Và AGI mà không làm chủ được thế giới vật lý thì không phải là AGI. Đó là lý do tôi đã tạo ra TUM CogBotLab cho robot học vào năm 2004 [5], đồng sáng lập một công ty về AI trong thế giới vật lý vào năm 2014 [6], và có các đội tại TUM, IDSIA, và hiện tại là KAUST làm việc hướng tới robot trẻ em [4,10-11,18]. Những robot mềm này không chỉ bắt chước con người một cách máy móc và chúng không hoạt động chỉ bằng cách tải xuống web như LLMs/VLMs. Không. Thay vào đó, chúng khai thác các nguyên tắc của Sự tò mò nhân tạo để cải thiện các Mô hình Thế giới thần kinh của chúng (hai thuật ngữ tôi đã sử dụng từ năm 1990 [1-4]). Những robot này làm việc với rất nhiều cảm biến, nhưng chỉ có các bộ truyền động yếu, để chúng không dễ dàng gây hại cho bản thân [18] khi chúng thu thập dữ liệu hữu ích bằng cách tự mình phát minh và thực hiện các thí nghiệm.

Điều đáng chú ý là, từ những năm 1970, nhiều người đã chế nhạo mục tiêu cũ của tôi là xây dựng một AGI tự cải thiện thông minh hơn tôi và sau đó nghỉ hưu. Tuy nhiên, gần đây, nhiều người cuối cùng đã bắt đầu nghiêm túc về điều này, và bây giờ một số người trong số họ đột nhiên quá lạc quan. Những người này thường không nhận thức được những thách thức còn lại mà chúng ta phải giải quyết để đạt được AI thực sự. Bài nói TED của tôi năm 2024 [15] tóm tắt một số điều đó.

TÀI LIỆU THAM KHẢO (dễ tìm trên web):

[1] J. Schmidhuber. Làm cho thế giới có thể phân biệt được: Về việc sử dụng mạng thần kinh tự giám sát hoàn toàn hồi quy (NNs) cho học tăng cường động và lập kế hoạch trong môi trường không ổn định. TR FKI-126-90, TUM, tháng 2 năm 1990, sửa đổi tháng 11 năm 1990. Bài báo này cũng giới thiệu sự tò mò nhân tạo và động lực nội tại thông qua mạng đối kháng sinh tạo nơi một mạng NN tạo ra đang đấu tranh với một mạng NN dự đoán trong một trò chơi minimax.

[2] J. S. Một khả năng để thực hiện sự tò mò và sự nhàm chán trong các bộ điều khiển thần kinh xây dựng mô hình. Trong J. A. Meyer và S. W. Wilson, biên tập viên, Proc. của Hội nghị Quốc tế về Mô phỏng Hành vi Thích nghi: Từ Động vật đến Animats, trang 222-227. MIT Press/Bradford Books, 1991. Dựa trên [1].

[3] J.S. AI Blog (2020). 1990: Lập kế hoạch & Học tăng cường với Mô hình Thế giới hồi quy và Sự tò mò nhân tạo. Tóm tắt các khía cạnh của [1][2] và nhiều bài báo sau này bao gồm [7][8].

[4] J.S. AI Blog (2021): Sự tò mò & Sáng tạo nhân tạo từ năm 1990. Tóm tắt các khía cạnh của [1][2] và nhiều bài báo sau này bao gồm [7][8].

[5] J.S. TU Munich CogBotLab cho robot học (2004-2009)

[6] NNAISENSE, được thành lập vào năm 2014, cho AI trong thế giới vật lý

[7] J.S. (2015). Về việc học cách suy nghĩ: Lý thuyết thông tin thuật toán cho các kết hợp mới của bộ điều khiển học tăng cường (RL) và Mô hình Thế giới hồi quy thần kinh. arXiv 1210.0118. Mục 5.3 mô tả một kỹ sư gợi ý RL học cách truy vấn mô hình của nó để suy luận trừu tượng và lập kế hoạch và ra quyết định. Ngày nay điều này được gọi là "chuỗi suy nghĩ."

[8] J.S. (2018). Một Mạng Lớn Cho Mọi Thứ. arXiv 1802.08864. Xem thêm bằng sáng chế US11853886B2 và tweet DeepSeek của tôi: DeepSeek sử dụng các yếu tố của kỹ sư gợi ý học tăng cường năm 2015 [7] và sự tinh chỉnh năm 2018 của nó [8] kết hợp máy RL và mô hình thế giới của [7] thành một mạng duy nhất. Điều này sử dụng quy trình chưng cất mạng thần kinh của tôi từ năm 1991: một hệ thống chuỗi suy nghĩ được chưng cất.

[9] J.S. Turing Bị Thổi Phồng. Tuy nhiên, đó không phải là lỗi của Turing. AI Blog (2021, từng đứng #1 trên Hacker News)

[10] J.S. Robot thông minh sẽ bị mê hoặc bởi cuộc sống. F.A.Z., 2015

[11] J.S. tại Falling Walls: Quá khứ, Hiện tại và Tương lai của Trí tuệ Nhân tạo. Scientific American, Observations, 2017.

[12] J.S. KI là một cơ hội lớn cho Đức. F.A.Z., 2018

[13] H. Jones. J.S. Nói rằng Công việc Cuộc đời của Ông sẽ Không Dẫn Đến Dystopia. Forbes Magazine, 2023.

[14] Phỏng vấn với J.S. Jazzyear, Thượng Hải, 2024.

[15] J.S. Bài nói TED tại TED AI Vienna (2024): Tại sao năm 2042 sẽ là một năm lớn đối với AI. Xem clip video đính kèm.

[16] J.S. Xây dựng robot đa năng điều khiển bởi AI! F.A.Z., 2024

[17] J.S. 1995-2025: Sự suy giảm của Đức & Nhật Bản so với Mỹ & Trung Quốc. Liệu Robot Đa Năng Có Thể Thúc Đẩy Sự Trở Lại? AI Blog, tháng 1 năm 2025, dựa trên [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Hướng tới một Robot Trẻ Em Cực Kỳ Bền Vững Với Khả Năng Tương Tác Phong Phú cho Các Thuật Toán Học Máy Tiên Tiến. Bản thảo arxiv 2404.08093, 2024.

67,12K

DeepSeek [1] sử dụng các yếu tố của kỹ thuật học tăng cường từ năm 2015 [2] và sự tinh chỉnh năm 2018 [3] mà hợp nhất mô hình máy học RL và mô hình thế giới của [2] thành một mạng duy nhất thông qua quy trình chưng cất mạng nơ-ron năm 1991 [4]: một hệ thống chuỗi suy nghĩ đã được chưng cất.

TÀI LIỆU THAM KHẢO (dễ dàng tìm thấy trên web):

[1] #DeepSeekR1 (2025): Khuyến khích khả năng lý luận trong LLMs thông qua học tăng cường. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Về việc học cách suy nghĩ: Lý thuyết thông tin thuật toán cho các tổ hợp mới của các bộ điều khiển học tăng cường và các mô hình thế giới nơ-ron hồi tiếp. arXiv 1210.0118. Mục 5.3 mô tả kỹ thuật học tăng cường (RL) mà học cách chủ động và lặp đi lặp lại truy vấn mô hình của nó để lý luận trừu tượng và lập kế hoạch cũng như ra quyết định.

[3] JS (2018). Một mạng lớn cho mọi thứ. arXiv 1802.08864. Xem thêm US11853886B2. Bài báo này hợp nhất người học tăng cường và mô hình thế giới của [2] (ví dụ, một mô hình nền tảng) thành một mạng duy nhất, sử dụng quy trình chưng cất mạng nơ-ron năm 1991 [4]. Về cơ bản, cái mà bây giờ được gọi là hệ thống "Chuỗi Suy nghĩ" RL, nơi các cải tiến tiếp theo liên tục được chưng cất vào một mạng duy nhất. Xem thêm [5].

[4] JS (1991). Học các chuỗi phức tạp, kéo dài bằng cách sử dụng nguyên tắc nén lịch sử. Neural Computation, 4(2):234-242, 1992. Dựa trên TR FKI-148-91, TUM, 1991. Người học sâu đầu tiên hoạt động dựa trên một hệ thống mạng nơ-ron hồi tiếp sâu (với các thang thời gian tự tổ chức khác nhau), vượt qua vấn đề gradient biến mất thông qua việc huấn luyện trước không giám sát (P trong CHatGPT) và mã hóa dự đoán. Cũng: nén hoặc chưng cất một mạng giáo viên (người phân đoạn) thành một mạng học sinh (người tự động hóa) mà không quên các kỹ năng cũ - những phương pháp như vậy hiện đang được sử dụng rộng rãi. Xem thêm [6].

[5] JS (AI Blog, 2020). Kỷ niệm 30 năm lập kế hoạch & học tăng cường với các mô hình thế giới hồi tiếp và sự tò mò nhân tạo (1990, giới thiệu các tín hiệu thưởng có chiều cao và nguyên tắc GAN). Chứa các tóm tắt của [2][3] ở trên.

[6] JS (AI Blog, 2021). Kỷ niệm 30 năm: Học sâu rất đầu tiên với việc huấn luyện trước không giám sát (1991) [4]. Mã hóa dự đoán phân cấp không giám sát tìm ra các đại diện nội bộ gọn gàng của dữ liệu tuần tự để tạo điều kiện cho việc học tiếp theo. Cấu trúc phân cấp có thể được chưng cất [4] thành một mạng nơ-ron sâu duy nhất. 1993: giải quyết các vấn đề độ sâu >1000.

787,12K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất