Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

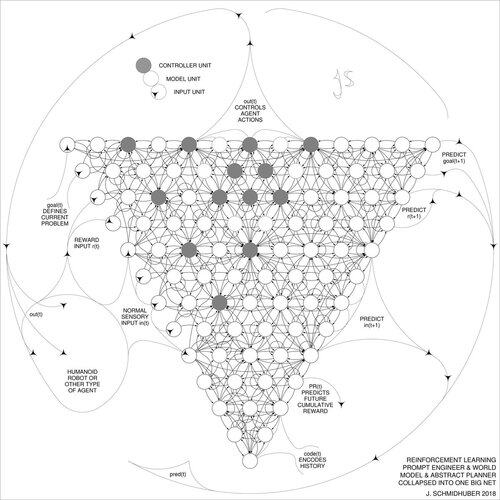

DeepSeek [1] sử dụng các yếu tố của kỹ thuật học tăng cường từ năm 2015 [2] và sự tinh chỉnh năm 2018 [3] mà hợp nhất mô hình máy học RL và mô hình thế giới của [2] thành một mạng duy nhất thông qua quy trình chưng cất mạng nơ-ron năm 1991 [4]: một hệ thống chuỗi suy nghĩ đã được chưng cất.

TÀI LIỆU THAM KHẢO (dễ dàng tìm thấy trên web):

[1] #DeepSeekR1 (2025): Khuyến khích khả năng lý luận trong LLMs thông qua học tăng cường. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Về việc học cách suy nghĩ: Lý thuyết thông tin thuật toán cho các tổ hợp mới của các bộ điều khiển học tăng cường và các mô hình thế giới nơ-ron hồi tiếp. arXiv 1210.0118. Mục 5.3 mô tả kỹ thuật học tăng cường (RL) mà học cách chủ động và lặp đi lặp lại truy vấn mô hình của nó để lý luận trừu tượng và lập kế hoạch cũng như ra quyết định.

[3] JS (2018). Một mạng lớn cho mọi thứ. arXiv 1802.08864. Xem thêm US11853886B2. Bài báo này hợp nhất người học tăng cường và mô hình thế giới của [2] (ví dụ, một mô hình nền tảng) thành một mạng duy nhất, sử dụng quy trình chưng cất mạng nơ-ron năm 1991 [4]. Về cơ bản, cái mà bây giờ được gọi là hệ thống "Chuỗi Suy nghĩ" RL, nơi các cải tiến tiếp theo liên tục được chưng cất vào một mạng duy nhất. Xem thêm [5].

[4] JS (1991). Học các chuỗi phức tạp, kéo dài bằng cách sử dụng nguyên tắc nén lịch sử. Neural Computation, 4(2):234-242, 1992. Dựa trên TR FKI-148-91, TUM, 1991. Người học sâu đầu tiên hoạt động dựa trên một hệ thống mạng nơ-ron hồi tiếp sâu (với các thang thời gian tự tổ chức khác nhau), vượt qua vấn đề gradient biến mất thông qua việc huấn luyện trước không giám sát (P trong CHatGPT) và mã hóa dự đoán. Cũng: nén hoặc chưng cất một mạng giáo viên (người phân đoạn) thành một mạng học sinh (người tự động hóa) mà không quên các kỹ năng cũ - những phương pháp như vậy hiện đang được sử dụng rộng rãi. Xem thêm [6].

[5] JS (AI Blog, 2020). Kỷ niệm 30 năm lập kế hoạch & học tăng cường với các mô hình thế giới hồi tiếp và sự tò mò nhân tạo (1990, giới thiệu các tín hiệu thưởng có chiều cao và nguyên tắc GAN). Chứa các tóm tắt của [2][3] ở trên.

[6] JS (AI Blog, 2021). Kỷ niệm 30 năm: Học sâu rất đầu tiên với việc huấn luyện trước không giám sát (1991) [4]. Mã hóa dự đoán phân cấp không giám sát tìm ra các đại diện nội bộ gọn gàng của dữ liệu tuần tự để tạo điều kiện cho việc học tiếp theo. Cấu trúc phân cấp có thể được chưng cất [4] thành một mạng nơ-ron sâu duy nhất. 1993: giải quyết các vấn đề độ sâu >1000.

787,02K

Hàng đầu

Thứ hạng

Yêu thích