Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

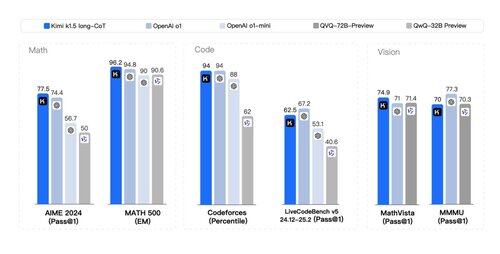

Dass ein *zweites* Papier mit einer Menge an RL-Flywheel-Geheimnissen und *multimodaler* o1-artiger Argumentation veröffentlicht wurde, steht heute nicht auf meiner Bingo-Karte. Die Papiere von Kimi (einem anderen Startup) und DeepSeek haben bemerkenswerterweise ähnliche Ergebnisse erzielt:

> Keine Notwendigkeit für komplexe Baumsuchen wie MCTS. Einfach die Gedankenverfolgung linearisieren und gute alte autoregressive Vorhersage machen;

> Keine Notwendigkeit für Wertfunktionen, die eine weitere teure Kopie des Modells erfordern;

> Keine Notwendigkeit für dichte Belohnungsmodellierung. So viel wie möglich auf Groundtruth, Endergebnis verlassen.

Unterschiede:

> DeepSeek verfolgt den AlphaZero-Ansatz - rein bootstrap durch RL ohne menschlichen Input, d.h. "kalter Start". Kimi verfolgt den AlphaGo-Master-Ansatz: leichtes SFT, um durch prompt-engineered CoT-Spuren aufzuwärmen.

> DeepSeek-Gewichte sind MIT-Lizenz (Thought Leadership!); Kimi hat noch keine Modellveröffentlichung.

> Kimi zeigt starke multimodale Leistung (!) bei Benchmarks wie MathVista, die visuelles Verständnis von Geometrie, IQ-Tests usw. erfordern.

> Das Kimi-Papier enthält VIEL mehr Details zum Systemdesign: RL-Infrastruktur, hybrider Cluster, Code-Sandbox, Parallelitätsstrategien; und Lern-Details: langer Kontext, CoT-Kompression, Lehrplan, Sampling-Strategie, Testfall-Generierung usw.

Optimistische Lektüre an einem Feiertag!

Whitepaper-Link:

300,45K

Top

Ranking

Favoriten