Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

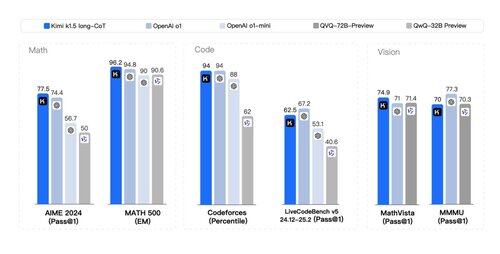

Việc một *bài báo thứ hai* được phát hành với hàng tấn bí mật về flywheel RL và lý luận *đa phương thức* kiểu o1 không nằm trong danh sách bingo của tôi hôm nay. Các bài báo của Kimi (một startup khác) và DeepSeek đã đáng kể hội tụ vào những phát hiện tương tự:

> Không cần tìm kiếm cây phức tạp như MCTS. Chỉ cần tuyến tính hóa dấu vết suy nghĩ và thực hiện dự đoán autoregressive cổ điển;

> Không cần các hàm giá trị yêu cầu một bản sao tốn kém khác của mô hình;

> Không cần mô hình thưởng dày đặc. Dựa vào sự thật, kết quả cuối cùng càng nhiều càng tốt.

Sự khác biệt:

> DeepSeek thực hiện phương pháp AlphaZero - hoàn toàn tự khởi động thông qua RL mà không cần sự can thiệp của con người, tức là "khởi động lạnh". Kimi thực hiện phương pháp AlphaGo-Master: SFT nhẹ để khởi động thông qua các dấu vết CoT được thiết kế theo prompt.

> Trọng số của DeepSeek có giấy phép MIT (lãnh đạo tư tưởng!); Kimi chưa có phát hành mô hình.

> Kimi thể hiện hiệu suất đa phương thức mạnh mẽ (!) trên các tiêu chuẩn như MathVista, yêu cầu hiểu biết về hình học, bài kiểm tra IQ, v.v.

> Bài báo của Kimi có rất nhiều chi tiết hơn về thiết kế hệ thống: cơ sở hạ tầng RL, cụm hybrid, sandbox mã, chiến lược song song; và chi tiết học tập: ngữ cảnh dài, nén CoT, chương trình học, chiến lược lấy mẫu, tạo trường hợp kiểm tra, v.v.

Đọc vui vẻ trong một ngày lễ!

Liên kết whitepaper:

300,45K

Hàng đầu

Thứ hạng

Yêu thích