Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

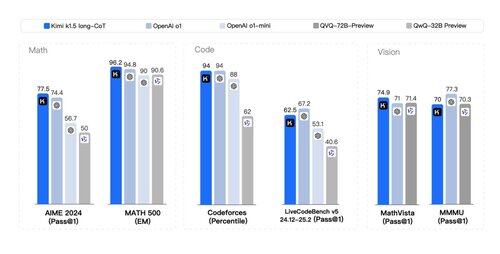

At en *andre* artikkel falt med tonnevis av RL-svinghjulshemmeligheter og *multimodal* o1-stil resonnement er ikke på bingokortet mitt i dag. Kimis (en annen oppstart) og DeepSeek's papirer konvergerte bemerkelsesverdig på lignende funn:

> Ingen behov for komplekst tresøk som MCTS. Bare lineariser tankesporet og gjør gode gamle autoregressive prediksjoner;

> Ingen behov for verdifunksjoner som krever en annen dyr kopi av modellen;

> Ikke behov for tett belønningsmodellering. Stol så mye som mulig på groundtruth, sluttresultat.

Forskjeller:

> DeepSeek gjør AlphaZero-tilnærming - rent bootstrap gjennom RL uten menneskelig input, dvs. Kimi gjør AlphaGo-Master-tilnærmingen: lett SFT for å varme opp gjennom hurtigkonstruerte CoT-spor.

> DeepSeek-vekter er MIT-lisens (tankelederskap!); Kimi har ikke en modellutgivelse ennå.

> Kimi viser sterk multimodal ytelse (!) på benchmarks som MathVista, noe som krever visuell forståelse av geometri, IQ-tester, etc.

> Kimi-artikkelen har MYE flere detaljer om systemdesignet: RL-infrastruktur, hybrid klynge, kodesandkasse, parallellitetsstrategier; og læringsdetaljer: lang kontekst, CoT-komprimering, læreplan, prøvetakingsstrategi, generering av testcaser, etc.

Optimistisk lesning på en ferie!

Lenke til whitepaper:

300,44K

Topp

Rangering

Favoritter