Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

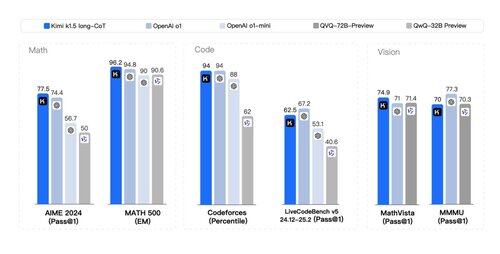

Que um *segundo* artigo tenha sido lançado com toneladas de segredos do flywheel de RL e raciocínio *multimodal* no estilo o1 não estava no meu bingo hoje. Os artigos da Kimi (outra startup) e da DeepSeek convergiram notavelmente em descobertas semelhantes:

> Não há necessidade de busca em árvore complexa como MCTS. Basta linearizar o traço de pensamento e fazer uma boa previsão autoregressiva;

> Não há necessidade de funções de valor que exijam outra cópia cara do modelo;

> Não há necessidade de modelagem de recompensa densa. Confiar o máximo possível na verdade de base, no resultado final.

Diferenças:

> A DeepSeek adota a abordagem AlphaZero - bootstrap puro através de RL sem input humano, ou seja, "cold start". A Kimi adota a abordagem AlphaGo-Master: SFT leve para aquecer através de traços de CoT projetados por prompt.

> Os pesos da DeepSeek são licenciados pelo MIT (liderança de pensamento!); a Kimi ainda não tem um lançamento de modelo.

> A Kimi mostra um desempenho multimodal forte (!) em benchmarks como MathVista, que requer compreensão visual de geometria, testes de QI, etc.

> O artigo da Kimi tem MUITO mais detalhes sobre o design do sistema: infraestrutura de RL, cluster híbrido, sandbox de código, estratégias de paralelismo; e detalhes de aprendizado: contexto longo, compressão de CoT, currículo, estratégia de amostragem, geração de casos de teste, etc.

Leituras otimistas em um feriado!

Link do whitepaper:

300,45K

Top

Classificação

Favoritos