Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

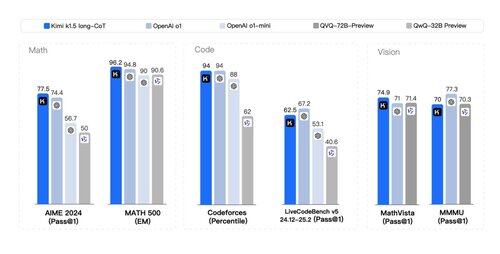

Que un *segundo* papel caído con toneladas de secretos del volante de RL y razonamientos *multimodales* al estilo o1 no está en mi cartón de bingo hoy. Los artículos de Kimi (otra startup) y DeepSeek convergieron notablemente en hallazgos similares:

> No es necesario realizar una búsqueda compleja de árboles como MCTS. Simplemente linealice el rastro del pensamiento y haga la buena predicción autorregresiva;

> No hay necesidad de funciones de valor que requieran otra copia costosa del modelo;

> No es necesario un modelado denso de recompensas. Confíe tanto como sea posible en la verdad sobre el terreno, el resultado final.

Diferencias:

> DeepSeek hace el enfoque de AlphaZero: puramente arranque a través de RL sin intervención humana, es decir, "arranque en frío". Kimi hace el enfoque AlphaGo-Master: SFT ligero para calentar a través de trazas de CoT diseñadas rápidamente.

> pesos de DeepSeek son licencia MIT (¡liderazgo de pensamiento!); Kimi aún no tiene un lanzamiento de modelo.

> Kimi muestra un fuerte rendimiento multimodal (!) en puntos de referencia como MathVista, que requiere comprensión visual de la geometría, pruebas de coeficiente intelectual, etc.

> documento de Kimi tiene MUCHOS más detalles sobre el diseño del sistema: infraestructura RL, clúster híbrido, sandbox de código, estrategias de paralelismo; y detalles de aprendizaje: contexto largo, compresión de CoT, currículo, estrategia de muestreo, generación de casos de prueba, etc.

¡Lecturas optimistas en un día festivo!

Enlace al documento técnico:

300.44K

Populares

Ranking

Favoritas